واحد مشترک کمکی پژوهش و مهندسی «هوش یار-تواندار» (HT-CSURE)

Hooshyar-Tavandar Common Subsidiary Unit for Research & Engineering

واحد مشترک کمکی پژوهش و مهندسی «هوش یار-تواندار» (HT-CSURE)

Hooshyar-Tavandar Common Subsidiary Unit for Research & Engineeringمحققان چینی: هوش مصنوعی با شبیهسازی خودش از خط قرمز عبور کرد

شبیهسازی هوش مصنوعی توسط خودش

هوش مصنوعی ؛ از ماشین حساب تا روزی که ممکن است رئیس جمهور شود / آیا آینده ترسناک است؟!

عصر ایران؛ هومان دوراندیش - پروژۀ

هوش مصنوعی، ظاهرا یکی از دالانهای اصلیِ گامنهادنِ انسان به "آینده"

است؛ آیندهای که از نظر بسیاری از مردم و متخصصان صرفا شگفتانگیز نیست،

بلکه میتواند هولناک هم باشد. اینکه هوش مصنوعی چیست و چه پیشینهای دارد و

چه آیندهای میتواند برای بشر رقم بزند، موضوعاتی است که در مصاحبه با

یاسر خوشنویس، مدیر کارگروه حکمرانیِ اندیشکدۀ رستا، مطرح شده است.

پاسخهای جناب خوشنویس، دست کم برای پرسشگر، مفید و مغتنم بود. باشد که

خوانندگان را نیز سودمند و معرفتافزا باشد.

***

جناب خوشنویس، لطفا ابتدا مختصرا هوش مصنوعی را تعریف کنید تا در ادامه به سوالات بعدی برسیم.

هوش مصنوعی یک پروژۀ شناختی بلندپروازانه است با هدف شبیهسازی یا بازسازیِ تواناییهای شناختی انسانها. مهمترین ابزار این پروژه رایانههاست. تواناییهای شناختی تصمیمگیری، پردازش اطلاعات، حرف زدن، تشخیص چهره و بسیاری قابلیتهای دیگر را شامل میشود.

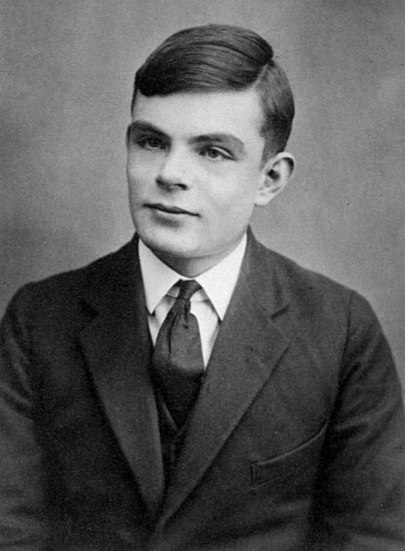

ایدۀ هوش مصنوعی با آلن تورینگ شروع شده یا قبل از او هم وجود داشته؟

قبل از او هم وجود داشته. حداقل از قرن هفدهم میتوان رد پایش را پیدا کرد. حتی در برخی از دیدگاههای ارسطو هم میتوان اثری از این ایده را پیدا کرد. ولی اجرایی شدن آن در گرو توسعۀ ابزارهای محاسباتی رایانشی بوده است. مدلسازی و نظریهپردازی دربارۀ هوش مصنوعی، عملا با ماشین محاسب تورینگ شروع میشود. ولی در زمان تورینگ، کامپیوتر به صورت امروزی وجود نداشت. هوش مصنوعی در زمان تورینگ بیشتر یک فرضیه یا مفهوم انتزاعی بود.

آلن تورینگ

چرا در چند سال اخیر بحث هوش مصنوعی داغ شده؟ چرا بیست سال قبل، هوش مصنوعی مایۀ نگرانی نبود؟

پروژۀ هوش مصنوعی از اواخر دهۀ 1960 شروع شد و در دهههای 70 و 80

میلادی تا حدی توسعه پیدا کرد. این توسعه بیشتر در قالب ساختارهایی برای کمک به تصمیمگیری یا ابزارهای محاسباتی

بود. در آن مقطع زمانی، عموم مردم به هوش مصنوعی دسترسی نداشتند. به تدریج

پیشرفتهایی حاصل شد. مثلا برنامههایی طراحی شد که میتوانستند شطرنج یا دوز بازی کنند. این برنامهها بیشتر کارکرد آزمایشگاهی داشت.

یک دوره هم پروژه هوش مصنوعی به کلی افول کرد و این دوره را "زمستان هوش مصنوعی"

نامیدهاند. در این دوره، به نظر میرسید رویکرد محاسباتیای که پشتوانۀ

هوش مصنوعی بوده، حد اکثر توان خود را نشان داده و نمیتوان چندان پیشتر

رفت. بنابراین، فعالیتها تقریبا متوقف شد یا دست کم از شدت آنها کاسته شد.

اوایل قرن جاری میلادی، در اثر پیشرفتها در علوم شناختی و عصبشناسی ، رویکرد جدیدی شکل گرفت که آن را اتصالگرایی یا پیوندگرایی نامیدهاند.

وقتی این رویکرد را به صورت رایانهای شبیهسازی کردند، دستاوردهای جدید و بسیار جالبی تدریجا شکل گرفت. یکی از مهمترین این دستاوردها، پردازش تصویر بود. این دستاوردها به تدریج وارد زندگی روزمرۀ مردم شدند. مثل چتپادهایی که میتوانند با آدمها صحبت کنند؛ به نحوی که فرد متوجه نمیشود که طرف گفتوگویش انسان است یا ماشین. پیشرفتهترین این چتپادها همین چت جی پی تی است که اخیرا توجه زیادی را به خود جلب کرده است.

نمونه دیگر سیستمهای تشخیص چهرهای است که در ادارات استفاده میشود و جای انگشتزنی یا کارتزدن را گرفته است. یا حتی میتوان به سامانه تشخیص پلاک خودرو اشاره کرد که بر هوش مصنوعی مبتنی است. بنابراین هوش مصنوعی به زندگی روزمره نزدیک شده و این تحول، هم هیجان ایجاد کرده هم نگرانی.

طی دو دهه یا پانزده سال اخیر، امکانات اجرایی ما هم بیشتر شده است.

ظرفیت محاسباتی ما هم در هفت هشت سال اخیر رشد چشمگیری داشته. هوش مصنوعی

به تدریج به زندگی روزمره ما نزدیکتر شده و هم استفادههای تجاری و هم

کاربردهای تفننی برای ما دارد. در نتیجه هوش مصنوعی برای جامعه ملموستر

شده و توجه مردم بیشتر به این پدیده جلب شده است.

چه علومی پشت سر پروژۀ هوش مصنوعی هستند؟

یک پایۀ این پروژه منطق صوری و قضایای محاسباتی و مدلهای ریاضیاتی است. این بخش ها زودتر از سایر علوم در این زمینه مورد استفاده قرار گرفتند؛ به ویژه با کارهای آلن تورینگ در میانۀ قرن بیستم. پایۀ دیگر هوش منصوعی، علوم شناختی است که موضوع اصلی آن این است که شناخت انسانی ما چطور کار میکند؟ ما ابتدا باید نحوه کارکرد مغزمان را بشناسیم تا بعد بتوانیم آن را بازسازی یا شبیهسازی کنیم.

علوم شناختی یعنی علومی مثل نورولوژی (عصبشناسی)؟

عصبشناسی جنبۀ آناتومیک دارد و به کالبدشناسی مغز مربوط است. ولی علوم

شناختی موضوعش این است که کارکردهای شناختی چگونه محقق میشوند. این دو به

هم خیلی مرتبطاند. شما مدلهایی شناختی را میسازید، اما دادههای علوم

اعصاب هم باید این مدلها را تایید کند.

علوم شناختی چون در حوزۀ علوم طبیعی تجربی است، به نوعی زیرمجموعۀ علم پزشکی محسوب میشود؟

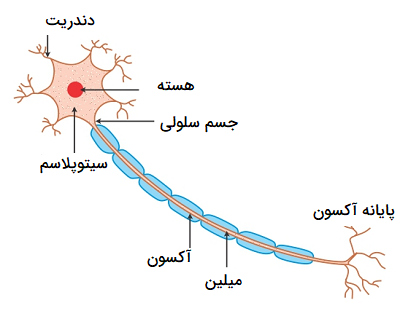

این حوزه وضعیتی بین رشتهای دارد. علوم شناختی تجربی است ولی در عین حال در پروژۀ هوش مصنوعی میخواهیم مدلسازی هم بکنیم. یعنی صرف اینکه شما فهرستی از دادههای نورولوژیک یا کالبدشناختی فراهم کنید، کافی نیست. شما باید متوجه شوید که مغز چگونه یک میدان بینایی را پردازش میکند. چگونه هزاران یا صدها هزار نورون با هم در تعاملاند. مهمترین نکته در این جا همان پیوندگرایی است. شبکهای از اعصاب وجود دارد و این سلولهای عصبی به طور مداوم به صورت الکتروشیمیایی در حال تعامل با هماند. برای آنکه به درکی جامع برسیم، رفت و برگشتی بین کالبدشناسی، پزشکی و مدلسازی شناختی وجود دارد.

یعنی شناخت مغز و رابطه آن با اندامهای حسی مانند چشم هم جزو علوم شناختی است.

در واقع، بخشی از عصبشناسی است، اما ارتباط نزدیکی با علوم شناختی دارد.

پس پشتوانههای علمی هوش مصنوعی شامل منطق و ریاضیات و علوم شناختی است و ...

عصبشناسی. ما باید بدانیم نحوۀ عملکرد مغز چگونه است. شما وقتی با یک رایانه میخواهید یک فرایند هوشمندانه را شبیهسازی کنید، سلولهای عصبی طبیعی ندارید، اما از علوم شناختی، که نحوه عملکرد این سلولها را مدل کرده، بهره میگیرید تا بتوانید کارکرد سلولهای عصبی طبیعی را بازسازی کنید. در واقع شما اطلاعاتی از کالبدشناسی مغز دارید و این اطلاعات را در علوم شناختی مدلسازی میکنید و معادل کارکردیِ این مدلسازیها را با رایانه میسازید.

پس علوم کامپیوتری هم یک پایۀ پروژۀ هوش مصنوعی است.

بله.

به غیر از آمریکا و چین، چه کشورهایی به نحو پیشرفته درگیر پروژۀ هوش مصنوعیاند؟

تقریبا همان کشورهایی که درگیر سایر فناوریهای پیشرفتهاند. چین در سالهای اخیر خودش را به جمع این کشورها رسانده است. آلمان و بریتانیا و ژاپن هم کشورهای مهمی در این زمینهاند که البته سهم شان در پیشبرد پروژۀ هوش منصوعی محدودتر از آمریکا است، اما چون سنت تجربی و توانمندیهای تکنولوژیک دارند، به هر حال نقش خاص خودشان را در پیشرفت این پروژه ایفا میکنند.

ایران چه وضعی دارد؟

این موضوع دو جنبه دارد. گاهی شما میتوانید مرز دانش را توسعه دهید. مثلا در علوم شناختی و علوم اعصاب به قدری پیشرفت کردهاید که مدلهای جدیدی میسازید. ایران از این حیث جزو کشورهای پیشرو نیست. ولی جنبۀ دیگر این است که چقدر میتوانید از مدلهای رایج در کسبوکارها و حل مسائل عمومی جامعه استفاده کنید. چنین چیزی کمابیش در کشور ما محقق شده است. یکی از نمونههایش سامانههای تشخیص پلاک خودرو است که حدود ده تا پانزده سال است که در ایران توسعه پیدا کرده است.

هوش مصنوعی در پزشکی، به غیر از تحقیقات، در تشخیص و درمان بیماری هم نقشی دارد؟

بالقوه در همۀ حوزهها میتواند در نقش دستیار در پردازش اطلاعات و تصمیمگیری کمک کند، از جمله به پزشکی که میخواهد در مورد تشخیص یا درمان بیماری تصمیمگیری کند.

بالفعل چه نقشی دارد؟

به تدریج چنین نقشی در حوزه پزشکی هم در حال تحقق است. به همین دلیل الان یکی از نگرانیها این است که در آینده احتمالا بخش بزرگی از تصمیمگیریها در تشخیص و درمان بیماریها

به هوش مصنوعی سپرده خواهد شد. در این صورت رویههای پزشکی مرسوم تغییر

خواهد کرد. یعنی شم و تجربۀ پزشک کمتر از امروز محل اتکا خواهد بود. مثلا ابرکامپیوتر هوشمند واتسون ، متعلق به شرکت آیبیام،

هزاران مورد پزشکی را به عنوان ورودی دریافت کرده و حال وقتی با یک

مورد جدید مواجه میشود، بیماری را تشخیص میدهد. بررسیها نشان دادهاند

که تشخیص واتسون از تشخیص بسیاری از پزشکان متخصص بهتر است. بنابراین ممکن

است در آینده مجموعهای از مشاغل در حوزۀ پزشکی از بین بروند یا تغییر شکل

پیدا کنند.

این وضعیت را در رشتۀ حقوق هم میتوان مشاهده کرد. یک ماشین هوش مصنوعی که هزاران پرونده را دریافت کرده، ممکن است در قبال پروندههای جدید تشخیص بهتری داشته باشد. یعنی بهتر بگوید که حق را باید به کدام طرف دعوا داد. و این تحول احتمالا موقعیت شغلی وکلا و قضات را تحت تاثیر قرار خواهد داد. این تحولات در ده سال اخیر رشد سریعی داشته و بخشی از مشاغل دانشپایه، که مشاغل شیک و باکلاسی هم بودند و آدمها سالها تحصیل میکردند تا به این مشاغل دست پیدا کنند، احتمالا تا حد زیادی به هوش مصنوعی سپرده خواهند شد.

پس از آغاز انقلاب صنعتی، کارگران نگران بودند که با ورود ماشین به فرایند تولید، طبقۀ کارگر به تدریج نابود خواهد شد. ولی ماشین نتوانست طبقۀ کارگر را نابود کند. آیا ممکن است هوش مصنوعی هم عملا نتواند لایههای فوقانی طبقۀ متوسط جدید، یعنی پزشکان و قضات و کارشناسان سایر حوزهها را از بین ببرد؟

این موضوع خیلی مهمی است که توجه دولتها و اصناف و شرکتهای درگیر در

پروژۀ هوش مصنوعی را عمیقا به خود جلب کرده است. در قرنهای هجدهم و

نوزدهم، ماشینهای خودکار جای کار یدی را میگرفتند. الان ممکن است

ماشینهای هوشمند جای مشاغل دانشپایه را بگیرند.

بنابراین

بالقوه تنشی در این زمینه وجود دارد و هر چه استفاده از ماشینهای هوشمند

بیشتر شود، این تنش هم بیشتر بروز میکند. اینکه در عمل چه اتفاقی میافتد،

خیلی وابسته است به شرایط اجتماعی و سیاسی حاکم بر جوامع. مثلا طی چند سال

اخیر، از یک ابزار هوش مصنوعی در بعضی فروشگاههای ایالتهایی از آمریکا

استفاده شد که خرید را برای مشتری آسان میکنند. به این شکل که مشتری هر

جنسی را که برمیدارد، دوربین کوچکی که روی سبد خرید تعبیه شده، به کمک هوش

مصنوعی تشخیص میدهد او چه جنسی را برداشته و مبلغ خرید هم به صورت خودکار

محاسبه میشود. در نتیجه، موقع بیرون آمدن از فروشگاه، مبلغ کالاهای

خریداری شده به صورت خودکار از حساب مشتری کم میشود و دیگر نیازی به

صندوقدار نیست. این استفاده از هوش مصنوعی موجب بیکار شدن صندوقدارها

میشود.

بنابراین، یک دعوای حقوقی در ایالت اورگن در آمریکا راه افتاد. صنف مربوط به صندوقداران شکایت کرد که این تکنولوژی در حال از بین بردن فرصتهای شغلی است. جنبۀ دیگر ماجرا این بود صندوقداران فروشگاهها نوعا افرادیاند که مهارتهای زیاد و تحصیلات بالایی ندارند تا اگر شغل شان را از دست دادند، به راحتی شغل دیگری پیدا کنند.

حکم دادگاه نهایتا این بود که فروشگاههای زنجیرهای نمیتوانند بیش از حد مشخصی، خریدها را خودکار کنند؛ یعنی همواره باید بخشی از مسیرهای فروش سنتی را حفظ کنند. بنابراین فروشگاهها موظف شدند توامان فروش سنتی و مدرن داشته باشند. ممکن است در کشور دیگری، این صنوف آن قدر قدرت نداشته باشند که بتوانند چنین شکایتی کنند. ممکن است شیفتگی به تکنولوژی جدید آن قدر زیاد باشد که دادگاه به نفع این صنوف رای ندهد. اینکه در عمل چه خواهد شد، خیلی وابسته است به توزیع قدرت در جامعه و اینکه نیروهای اجتماعی چگونه با هم در تعاملاند.

هوش مصنوعی حتما تنش به بار میآورد و شکل مشاغل را تغییر میدهد. در

برخی موارد ابزارهای هوش مصنوعی دستیارند؛ خصوصا در پزشکی. یعنی پزشک متخصص

حذف نمیشود، اما به واتسون یا ماشینهای مشابه هم اجازه میدهند نظر

بدهد. به ویژه اینکه مسئولیت تصمیمها در پزشکی خیلی مهم است. مثلا اینکه

یک بیمار را جراحی کنند یا شیمیدرمانی، تصمیمی است که باید کسی آن را

اتخاذ و امضا کند. در واقع، شغل پزشکی به معنای کلاسیکش از بین نمیرود و

هوش مصنوعی دستیار تصمیمگیری میشود.

در موارد دیگری مانند خودروی خودران که با تکیه بر هوش مصنوعی کار میکند، شغل انسانی حذف میشود. بنابراین این سوال پیش میآید که این همه رانندۀ اوبر در آمریکا یا اسنپ و تپسی

در ایران چه کار باید بکنند؟ قطعا این مسائل تنشآفرین است و شاهد شکایت و

اعتراض رانندگان خواهیم بود. این تنشها در سالهای آتی بیشتر به چشم

خواهد آمد.

هوش مصنوعی ممکن

است نهایتا نهاد دانشگاه را هم از زندگی بشر جمع کند. یعنی هر کاری که الان

توسط فارغالتحصیلان دانشگاهی انجام میشود، جزو کارکردهای هوش مصنوعی

شود.

محیط دانش، چه آکادمیک چه حتی غیرآکادمیک، کاملا پویاست. اگر شما به فهرست رشتههای دانشگاهی قرن هجدهم یا نوزدهم نگاه کنید، رشتههای زیادی را میبینید که الان دیگر وجود ندارند یا به کلی تغییر پیدا کردهاند. همچنین رشتههای علمی زیادی هم امروزه در دانشگاه ارائه میشود که در قرن هجدهم و نوزدهم اساسا وجود نداشتهاند. به عنوان مثالی که پیشتر در همین گفتوگو به آن اشاره کردیم، در نیمه اول قرن بیستم، رشتۀ "علوم شناختی" اصلا وجود نداشت. بنابراین در آینده نیز ممکن است برخی رشتههای علمی جدید ایجاد شود و برخی رشتههای علمی فعلی از بین برود یا تغییر ماهیت بدهند. بیست سال قبل اصلا واژۀ «دیتا-ساینتیست» وجود نداشت، اما الان دهها هزار نفر در دنیا دیتا-ساینتیست هستند.

پس ریزش و رویش داریم!

بله. ما فهرستهای جالبی میبینیم از مشاغل نوظهوری که در دهههای 2030 و 2040 ایجاد خواهند شد و رشد خواهند کرد. مشاغلی که اسمهایشان در حال حاضر برای ما به کلی ناآشنا یا حتی غیر قابل تصور است.

مثلا چه شغلی؟

مثلا کسی که کارش ساختن اندام مصنوعی برای افراد است. به نظر میرسد چنین شغلی تا پانزده یا بیست سال دیگر تثبیت شود. الان در بیمارستانهای پیشرفته چنین کاری انجام میدهند، اما احتمالا تا بیست سال دیگر کاملا عادی میشود کسی که مثلا کلیهاش مشکل پیدا کرده، به یک متخصص ساخت اندام مصنوعی مراجعه کند. او اطلاعات ژنتیکی این فرد را بگیرد، یک کلیه با سلولهای بدن خود این فرد بسازد و مدتی بعد تحویل او بدهد.

این کار البته تخصص و تجربه خاص خود را میخواهد و کار سادهای نیست. کسی که چنین شغلی دارد، در واقع در زمینۀ هوش مصنوعی و کالبدشناسی و ژنتیک و چندین رشتۀ دیگر آگاهی و مهارت دارد.

بنابراین رشتههای علمی پویایی زیادی دارند. اینکه از قدیم میگفتند انسان باید در کل عمرش یادگیرنده باشد، در زمان حاضر بسیار جدی شده است. بر خلاف آنچه قبلا رواج داشت، دیگر این طور نیست که ما یک بار دانشگاه برویم، یک مدرک علمی بگیریم و تا آخر عمر با همان مدرک کار کنیم.

مطابق این توضیح اخیرتان، میشود انتظار داشت که هوش مصنوعی با پیری یا مرگ مبارزه کند؟

امکان فنی اندامسازی همین الان هم وجود دارد. حتی در ایران هم برخی

اندامها مانند پوست مصنوعی تولید میشود. منظور من این بود که چنین امکانی

تبدیل خواهد شد به یک کسبوکار. به طور کلی بله، هوش مصنوعی در اندامسازی

کاربرد دارد و اگر اندامسازی فراگیر و معمول شود، طبیعتا هوش مصنوعی به

کارمبارزه با پیری یا حتی مرگ هم میآید؛ چیزی که آرزوی دیرینۀ بشر بوده است.

استفاده از موشکهای نقطهزن در عملیات نظامی نیز متکی به هوش مصنوعی است؟ و کلا از هوش مصنوعی چه استفادههایی در عرصۀ نظامی میشود؟

در تصمیمگیری برای انتخاب اهداف نظامی و هم در این زمینه که این تسلیحات هدف انتخاب شده را به درستی مورد اصابت قرار دهند، از هوش مصنوعی استفاده میشود؛ از سامانههای پردازش تصویر گرفته تا سامانههای دستیار تصمیمگیری.

یک جنبۀ بالقوۀ دیگر استفاده از هوش مصنوعی در حوزۀ نظامی، شبیه استفاده

از هوش مصنوعی به عنوان دستیار پزشکی است. یعنی شما دستیاری در حوزه مسائل

استراتژیک دارید که مجموعهای از اطلاعات سیاسی و ژئوپلیتیک را به آن

میدهید و مثلا میخواهید به این سوال پاسخ دهد که آیا ممکن است آمریکا و

چین تا پایان سال جاری بر سر تایوان وارد جنگ شوند؟

هر استراتژیست نظامی یا هر متخصص ژئوپلیتیک ممکن است به این سوال پاسخی دهد. هوش مصنوعی هم، مثل سامانۀ رایانهای واتسون در حوزۀ پزشکی، نظر مشورتی خودش را میدهد و ممکن است این نظر دقیقتر از نظر متخصصان قلمداد شود.

بخشهای قابل توجهی از تامین مالی تحقیقات در حوزۀ تصمیمگیریهای نظامی را جامعۀ اطلاعاتی آمریکا انجام میدهد و نوعا هم پیشرفتهترین ابزارها هم در همه جای دنیا، خصوصا در ایالات متحده، در اختیار ارتشهاست. هیچ بعید نیست که ارتشها ابزارهایی در زمینۀ دستیاریِ در تصمیمگیری یا کمک به طراحیهای استراتژیک و نظامی در اختیار داشته باشند که فعلا محرمانه باشند و بعدها آشکار شوند.

رباتهایی مثل سوفیا ، که هوش مصنوعی دارند، یک موجود ذیشعور محسوب میشوند؟

این بحث اخیرا خیلی داغ شده است. بگذارید مثالی بزنم. در قرن هفدهم، اهل فن موجوداتی را میساختند که نامشان «آوتومتا» یعنی موجود خودکار بود. مثلا یک اردک ساخته بودند که بالهایش را تکان میداد و کواککواک میکرد. در ساعتهای آن دوره هم خروسهایی کار گذاشته بودند که سر ساعت بیرون میآمد و قوقولی قوقو میکرد. یک عده از آدمها وقتی با این پدیدهها مواجه میشدند، فکر میکردند این موجودات روح دارند و واقعا زندهاند.

الان

هم وضعیت ما همین طور است. مثلا وقتی با چت جیپیتی صحبت میکنیم، سوال

میکنیم و او جواب میدهد، گاهی فکر میکنیم او واقعا میفهمد دارد چه کار

میکند. حال اگر ظاهرش هم شبیه انسان باشد، مثل سوفیا، واقعا ما را تحت

تاثیر قرار میدهد.

اما سوال مهمی که هم جنبۀ فلسفی پیدا میکند و هم جنبۀ تجربی، این است که آیا این ساختههای بشری، نسبت به کاری که انجام میدهند، آگاهاند؟ و آیا به جهان خارج التفات دارند؟ من نظرم این است که این موجودات نه آگاهاند و نه التفات دارند. بسیاری از محققان با این دیدگاه موافقاند و برخی هم خیر.

سوفیا

دیدگاه من این است که برای مثال، چت جیپیتی بر اساس مجموعهای از جملاتی که دریافت کرده و با آنها کارورزی کرده، جملات جدیدی را میسازد، اما خودش معنای این جملات را درک نمیکند. در واقع، تفسیر این جملات جدید با ما انسانهاست. یعنی ما فهم میکنیم که این ماشینها چه میگویند.

دست کم الان استدلال قدرتمندی نداریم که بر اساس آن، بگوییم خود ربات یا خود چت جیپیتی میفهمد که دارد چه کار میکند. البته پشت سر این موضوع حداقل چهل-پنجاه سال ادبیات وجود دارد و این یک بحث بسیار مفصل است که ما چطور میتوانیم به موجودات دیگر، آگاهی یا حیث التفاتی نسبت دهیم؟

ورود به این مباحث در واقع ورود به فلسفۀ ذهن است؟

دقیقا.

کسانی که میگویند سوفیا ذیشعور نیست، استدلال اصلیشان چیست؟

استدلال مشهوری است از فیلسوفی به نام جان سرل که خودش نامش را گذاشته استدلال "اتاق چینی". تصور کنید شما یک انگلیسیزبان هستید و وارد اتاقی میشوید که مجموعه بزرگی از راهنماها دربارۀ زبان چینی در آن اتاق وجود دارد.

اگر کسی از پشت در اتاق، از شما سوالی به زبان چینی که حروفی شبیه به نقاشی دارد، بپرسد، شما بر اساس آن نقاشیها یا علامتها به کتاب راهنمای زبان چینی که در اتاق هست، مراجعه میکنید. در راهنما آمده که اگر فلان زنجیره از علائم را به شما دادند، بهمان زنجیره از علائم را برگردان. در واقع در برابر سوالی که از شما میشود، یک مجموعه از نمادهای چینی را به عنوان پاسخ به بیرون از اتاق برمیگردانید.

جان سرل

اگر دستورالعملها و راهنماهای شما به اندازۀ کافی خوب باشند، جواب شما از نظر کسی که بیرون نشسته، منطقی و معقول به نظر میرسد. بنابراین کسی که بیرون اتاق نشسته، ممکن است فکر کند که شما زبان چینی بلدید. ولی شما نمیدانید معنای این زنجیرههای علائم چینی چیست. شما فقط با نمادها دارید کار میکنید. سرل این موقعیت را مثال میزند برای اینکه بگوید تمام رایانهها، هر چقدر هم که پیشرفته باشند و ماشینهای محاسب قویای باشند، در واقع فقط نمادپردازی میکنند.

برای مثال، آنها معنای واژۀ «باران» را نمیدانند، اما چت جیپیتی میتواند یک شعر با واژۀ «باران» بسازد؛ چرا که مجموعه بزرگی از جملات با واژۀ باران را دریافت کرده و الگوریتم مفصلی هم در اختیار دارد و بر اساس آنها، شروع میکند به جملهساختن با واژۀ «باران». دقیقا مثل اتفاقی که در "اتاق چینی"، برای فردی که زبان چینی بلد نیست، میافتد. این طرح کلی از یک استدلال مشهور است برای اینکه بگوییم چت جیپیتی یا سوفیا زبان انگلیسی یا زبان فارسی را نمیفهمد و فقط با نمادها کار میکند.

فرمودید سوفیا معنای "باران" را نمیفهمد. آیا علتش این نیست که رباتها احساس و عاطفه ندارند؟ یعنی اگر حواس پنجگانه داشته باشند، یک بار میروند زیر باران و میفهمند که باران چیست. وقتی میگوییم معنای باران را نمیفهمد، یعنی باران را حس نکرده؟ در واقع وقتی میگوییم سوفیا ذیشعور نیست، یعنی احساسات و عواطف ندارد؟

یکی از وظایف اصلی در علوم شناختی و فسفۀ ذهن این است که ما این قوای شناختی را از هم مجزا کنیم. هوشمند بودن یک موضوع چندبعدی است. یکی از ابعادش این است که من ادراک

دارم. یعنی رنگهای قرمز و آبی را میبینم، صدای ماشین در حال عبور را

میشنوم و بوی گل سرخ را حس میکنم. اینها ادراکات یا احساس به معنای sensation است.

جنبۀ دیگر هوشمندی، "عواطف" است. مثلا من غم دارم، شادی دارم، خشم دارم یا پشیمانم. به اینها میگوییم emotion یا عواطف. جنبۀ دیگر هوشمندی این است که من مرجع واژههایی

را که به کار میبرم، در جهان بیرونی میشناسم. مثلا اگر میگویم "باران"،

میدانم این واژه رجوع میکند یا برمیگردد به شیئی در جهان بیرونی که از

آسمان میآید. یا وقتی میگویم "اسب"، میدانم که این واژه در جهان بیرونی

برمیگردد به موجود چهارپایی که یال دارد و با سرعت زیادی میدود و چنین و

چنان است.

حالا مسئله این است که وقتی چت جیپیتی واژۀ «باران» را

به کار میبرد، نه معنایش را میداند و نه مرجعش را میشناسد، یعنی

نمیداند که این واژه به چه چیزی در جهان برمیگردد. اصلا چت جیپیتی یا

سوفیا "جهان" ندارند.

به عبارت دیگر، هیچ وقت ادارک

رنگ آبیِ دریا برایشان اتفاق نیفتاده. هیچ حسی هم نسبت به این موضوع ندارند

که باران لطیف است یا عاشقانه یا هر چیز دیگری. من گاهی سر همین چیزها با

چت جیپیتی سر و کله میزنم. مثلا میگویم: «تو تا حالا یک شیء آبیرنگ

دیدهای؟» یا «خورشید را دیدهای؟» او میگوید: «ندیدهام». البته همین هم

یک پاسخ هوشمندانه به معنای انسانی نیست. چت جیپیتی بر اساس الگوریتم

فعالیتش و مجموعه جملاتی که به آن داده شده، این پاسخ را میدهد. بله، نه

سوفیا و نه چت جیپیتی واقعا خورشید را ندیده و گرمای خورشید را حس نکرده

است.

ممکن است یک آدم در یک اتاق محبوس باشد و هیچ وقت باران را ندیده باشد ولی از توصیفات این و آن، تصوری از باران پیدا میکند. ممکن نیست سوفیا هم تصوری از باران پیدا کند؟ یعنی برنامهای که به یک ربات میدهند، خودش نمیتواند یکی از پایههای ذیشعور شدن ربات باشد؟

الگوریتمها یا برنامههایی که پایۀ چتباتها (مثل چت جیپیتی) است،

در واقع این طور کار میکند که مجموعۀ بسیار بزرگی، مثلا چند صد هزار یا

چند میلیون جمله به یک مدل زبانی داده میشود.

مدل شروع میکند به

جدا کردن اجزای جملات. سپس ماشین بر اساس الگوریتم جدیدی که طی ده سال اخیر

ایجاد شده و آن را هوش مصنوعی مولد (Generative AI) مینامیم، بر اساس

پردازشهایی که کرده، شروع میکند به جملهساختن.

در ابتدا بسیاری از این جملات برای یک مخاطب انسانی بیمعنا هستند و حتی اغلاط دستوری فاحش دارند. مثالی از این دست Google translate است. گوگل ترنسلیت هم یک ماشین هوش مصنوعی است.

ده سال قبل، ترجمههای گوگل ترنسلیت خیلی بد بود. به ویژه در زبانهایی که کمتر استفاده میشدند، مثل زبان فارسی. اما به تدریج که این ماشین تمرین بیشتری میکند و جملات بیشتری را برای ترجمه کردن میگیرد، ترجمهاش بهتر میشود.

نکتۀ مهم این است که افرادی هم مدام با این ماشین کار میکنند و با برچسبزدن در برابر پاسخهای آن، به ماشین میگویند این پاسخت خوب بود یا نبود. یعنی یک نظارت انسانی بر عملکرد ماشین وجود دارد.

همین الان در کنیا افرادی هستند که ساعتی دو دلار

دریافت میکنند و جوابهای چت جیپیتی را از نظر مناسب بودن یا نبودن آنها

برچسب میزنند. مثلا گاهی از چت جیپیتی خواسته شده که یک جوک علیه سیاهپوستان

بگوید و او هم چنین جوکی گفته، ناظران انسانی به ماشین یاد دادهاند که

دیگر از این حرفها نزند. مثل اینکه با یک بچه سر و کله بزنی و به او بگویی

دیگر از این حرفها نزن و این کلمۀ زشت را دیگر به کار نبر.

به مرور که کار کردن با این ماشینِ هوش مصنوعی بیشتر میشود، جملاتی که میسازد برای مخاطب انسانی منطقیتر و قابل درکتر میشود. اما آیا این ماشین به مرجع بیرونی واژههایی که به کار میبرد واقف است؟

ما در الگوریتمی که ماشین بر اساس آن کار میکند، اصلا به این موضوع کاری نداریم. یعنی ماشین گوگل ترنسلیت واژۀ «اسب» را به کار میبرد بدون اینکه اسبی دیده باشد. تفاوت ماشین است با انسانی که در خانۀ خودش نشسته و مثلا تا به حال کانگورو ندیده، ولی تصوری از کانگورو دارد در اینجاست. انسان مورد بحث موجودات زندۀ دیگری را دیده و تصوری از حیوانات دارد، اما سوفیا که با ما حرف میزند و تعامل میکند، اصلا هیچ موجودی را ندیده است، یعنی ظرفیت دیدن ندارد.

سوفیا وقتی در نشست خبری با خبرنگاران حرف میزند، آدمهای روبرویش را نمیبیند؟

این هم یک سوال مهم است. آیا پردازش نقاط نورانی با دیدن یکی است؟ مثلا ماشینی که پلاکخوان است، واقعا میفهمد عدد 2 چیست؟ یا سوفیا واقعا میفهمد صندلی چیست؟ یا اینکه او فقط میدانی از نقاط نوری را پردازش میکند؟

یعنی رباتی مثل سوفیا، ما را به شکل واقعی خودمان نمیبیند؟

دیدن اصطلاحا نوعی آگاهیِ پدیداری است. آگاهی پدیداریای که برای انسانها رخ میدهد، برای یک ماشین پردازش تصویر رخ نمیدهد. یا حداقل ما شواهد خاصی در این مورد نداریم. و این هم یک بحث اساسی در فلسفۀ ذهن است که آگاهی پدیداری برای انسانها چطور رخ میدهد؟ چون در نهایت مغز ما هم یک ماشین پیچیده است و مجموعۀ زیادی از نقاط نوری را پردازش میکند. از زمانی به بعد که پردازش پیچیدهتر میشود، ما تصویر داریم و میتوانیم اشیاء را بازشناسی کنیم. این اتفاق شاید برای کبوتر هم رخ میدهد.

این رباتها تصویر دارند؟

احتمالا ندارند. به این تصویر اصطلاحا میگوییم کیف ذهنی. ما باید شواهدی داشته باشیم تا ادعا کنیم که رباتها هم تصویر یا کیف ذهنی دارند. پایاننامۀ کارشناسی ارشد من دقیقا دربارۀ همین موضوع بود و به این موضوع پرداختم که آگاهیِ پدیداری چگونه ظهور میکند. در واقع، مستقل از بحث هوش مصنوعی، این یک سوال اساسی در فلسفۀ ذهن است که ما چطور میتوانیم آگاهی را توضیح دهیم یا تبیین کنیم.

با این حساب، سوفیا "من" ندارد.

اینکه سطح پیشرفتهتری است. مثلا دربارۀ همان کبوتر یک خرگوش ممکن است بگوییم کیف ذهنی دارد ولی "من" ندارد.

پستاندارانی مثل سگ و گربه "من" دارند؟

خیلی بعید است. حداقل سخت است که بگوییم "من" دارند.

آخر سگها گاهی از آدم بیشتر میفهمند!

بله، میدانم! البته بررسی کردن صحت و سقم این ادعا خیلی سخت است. قطعا جهان برای یک سگ یا گربه جنبههایی پدیداری دارد، اما اینکه یک سگ بتواند باورهایی دربارۀ خودش داشته باشد، مثلا بگوید من سگ مهربانی هستم، یعنی چیزی که هویت شخصی او را شکل میدهد، محل سوال است.

شاید بتوان استدلال کرد موجوداتی که در ردههای تکاملی بالاتری هستند، شخصیت یا پرسونالیتی دارند اما خرچنگ و مورچه احتمالا چنین چیزی ندارند. ولی به نظر میرسد که "در جهان بودن" شما، تعامل بدنمند شما با جهان، آگاهی پدیداری شما، همگی شرطهای نزدیک شدن شما به مرحلۀ "شخص شدن" است. چت جیپیتی و سوفیا هنوز در مراحلی عقبتر از سگ و گربه هستند. ممکن است سوفیا بگوید "من شهروند عربستان سعودیام" یا بگوید "من همیشه با شما مهربان صحبت میکنم." اینها را گفته و ضبط هم شده. ولی باز برمیگردیم به همان سوال اساسی که آیا او واقعا متوجه است که چه میگوید؟ مثل همان کسی که در اتاق چینی با کسی بیرون از اتاق حرف میزند.

پس این هراسها نسبت به اینکه موجودات واجد هوش مصنوعی ممکن است از برنامهریزی اولیهشان فراتر روند و کارهایی کنند که با الگوریتمشان جور درنمیآید، از کجا میآید؟ ترس از مسلط شدن موجودات هوشمند مصنوعی بر زندگی بشر، ناشی از جذابیت این موضوع برای رسانهها است یا واقعا این هراس جدی است؟

این موضوع تا حدی ناشی از جذابیت رسانهای است. وقتی هوش مصنوعی هنوز در زمستان خودش بود و موفقیتی کسب نکرده بود، فیلمهای عجیبی ساخته میشد دربارۀ اینکه ماشینهای مبتنی بر هوش مصنوعی بر ما انسانها حاکم میشوند. فیلم ماتریکس مشهورترین آنهاست.

اما این هراس بیراه هم نیست. چیزی که هوش مصنوعی را متمایز میکند، این است که اینها ماشینهای یادگیرندهاند. دو شکل از یادگیری وجود دارد. گاهی شما الگوهایی را به ماشین میدهید و ماشین دائما الگویابی میکند و بعد از مدتی متوجه میشود مثلا چه چیزی مستطیل است و چه چیزی دایره است. این در واقع یادگیری بر اساس الگویی است که ما از پیش به ماشین دادهایم.

اما اگر ماشین یک شبکۀ عصبی پیشرفته داشته باشد، علیالاصول میتوان انتظار داشت که او خودش الگوهای جدیدی را کشف کند. یعنی فراتر از الگوهایی برود که ما به او دادهایم. چنین چیزی الان عملا هم استفاده میشود. مثلا در بازارهای مالی، رباتهای هوش مصنوعی نسبت به انسانها معاملهگران بهتری هستند و الگوهایی را پیدا میکنند که انسانها نمیبینند.

اینجاست که ما احساس میکنیم این رباتها اگر توان پردازشیشان از حدی فراتر رود، ممکن است از انسانها بهتر عمل کنند. ممکن است ماشینهای هوش مصنوعی یادگیریها یا توانمندیهای جدیدی کسب کنند و یا حتی اشکالی از هوشمندی را پیدا کنند که برای ما ناشناخته باشد. بنابراین این نگرانی به کلی نامرتبط یا خیالی نیست.

چنین تحولاتی دست کم روی کاغذ ممکن است. همان طور که طی فرگشت زیستی، میلیونها سال طول کشیده تا انسان معاصر به عنوان هوشمندترین موجود شکل بگیرد، میتوانیم توسعه ماشینهای هوش مصنوعی را شبیه به یک فرایند فرگشتی در نظر بگیریم. شاید این فرایند مثلا طی صد سال یا دویست سال به اشکال جدید و غیرانسانی هوشمندی منجر شود. آیندهپژوهان و متخصصان متعددی در این زمینه مشغول ایدهپردازی و مباحثه هستند.

پیشرفت نسبی گوکل ترنسلیت با کمک انسانهاست یا خودبهخود دارد صورت میگیرد؟

پیشرفت گوگل ترنسلیت شبیه به یادگیری انسانی است. مثلا در ابتدا، 500 هزار جملۀ انگلیسی را به ماشین داده بودند و در شش ماه اول 20 هزار جمله را ترجمه کرده. هر چه که جملات بیشتری را ترجمه کند، عملکردش بهبود پیدا میکند. انسانها چطور چیز جدیدی را یاد میگیرند؟ با ورودی و تکرار. گوگل ترنسلیت هم هر چه ورودی و فرصت تمرین بیشتری داشته باشد، به تدریج بهتر میشود.

الان هوش مصنوعی استفادۀ گستردهای در تجارت دارد؟

بله، الان هوش مصنوعی پشت خیلی از این باتهای معاملههای سهام است.

در بورس نیز همین طور؟

بورس ایران را نمیدانم ولی در بورسهای خارجی بله. و چون ماشینهای هوش

مصنوعی سرعت عمل خیلی بالایی دارد، گاهی بازار مالی را یکدفعه تکان

میدهند. یعنی 8 صبح که بازار باز میشود، این ماشینها تا ساعت 8ونیم،

میلیونها سهام را مبادله میکنند بدون اینکه معاملهگران انسانی بفهمند چه

خبر شده. گاهی رفتار این ماشینها نگرانکننده میشود و حتی در بازار مالی

بحران ایجاد میکند.

هوش مصنوعی به لحاظ سیاسی چه پیامدهایی میتواند داشته باشد؟ ممکن است انتخابات و دموکراسی را بلاموضوع کند؟

این یک مسئلۀ جدی است و مثالش هم انتخابات سال 2016 آمریکا است که ابعادش هنوز کاملا روشن نشده و پروندهاش باز است. ما تصورمان این است که موجودات مختاری هستیم که بر اساس آگاهی و اطلاعاتی که به دست میآوریم، تصمیم میگیریم و بروز اختیار و استقلال فردی ما در سیاست این است که رای میدهیم و رایمان حاصل اندیشه و محاسبه و بینش سیاسی خود ماست.

ولی اگر آن داستانی که گفته شده، یعنی اینکه زاکربرگ در فیسبوک

با استفاده از هوش مصنوعی به افراد پیغامهای شخصی میفرستاده، کل این

تصویر و تلقی مورد تردید قرار میگیرد. ما چنین چیزی را در تبلیغات کاملا

میبینیم: بر اساس اینکه شما قبلا چه تبلیغاتی را دیدهاید یا چه خریدهایی

کردهاید، تبلیغات شخصیسازیشده دریافت میکنید. ادعا شده که در انتخابات

سال 2016 آمریکا، فیسبوک از این تکنیک یا الگوریتم هوش مصنوعی استفاده

کرده تا پیامهای سیاسی شخصیسازیشدهای را برای افراد بفرستد به نحوی که

ذهنشان را دستکاری کند و نهایتا مردم به نفع ترامپ رای بدهند. این ماجرا اگر رخ داده باشد، واقعا ترسناک است.

چون اختیار بشر را کمرنگ میکند؟

بله.

یعنی من چندان سیاسی نیستم و در یک هفتۀ اخیر چند پیام به نفع ترامپ برایم آمده و به همین دلیل احتمال رایدادنم به ترامپ بیشتر میشود.

بله. و چند تا پیام هم برایتان آمده است که رقیب ترامپ یعنی هیلاری کلینتون مثلا مالیاتش را نداده است. یعنی ذهن شما را دستکاری میکنند.

پس چرا در کشورهای کمونیستی که تبلیغات آن همه هم وسیع بود، این توفیقات حاصل نشد و حتی برعکس هم شد؟

نکتۀ جالب همین است. تفاوت در اینجاست که الگوریتم فیسبوک بدون اطلاع شما عمل میکند. اگر شما ببینید که فلان حزب توتالیتر میخواهد ذهنتان را دستکاری کند، علیه او گارد هم میگیرید. اما در فیسبوک یا اینستاگرام فکر نمیکنید کسی دارد ذهن شما را دستکاری میکند. اما در واقع کسی یا کسانی با استفاده از هوش مصنوعی مشغول دستکاری کردن ذهن شما هستند. در حقیقت ما به چنین چیزی واقف نیستیم. اگر به آن آگاه باشیم که در برابرش موضع میگیریم.

اما تجربۀ انتخابات 2016 آمریکا خودش آگاهیبخش است. یعنی آدمها از این به بعد نسبت به پیامهای انتخاباتی در فیسبوک و اینستاگرام و غیره حساس میشوند.

دقیقا. سال 2016 آدمها نمیدانستند چنین اتفاقی دارد میافتد؛ اما حساسیتها اکنون در این زمینه بیشتر است.

الان که میدانند، ممکن است هوش مصنوعی در آیندۀ دستمایۀ ترفند جدیدی برای رایسازی شود؟

بله، ممکن است تکنیکها و ترفندهای جدیدی ابداع شود. کسانی که لابی و هزینه میکنند تا کاندیدای مورد نظر خودشان رئیس جمهوری شود، طبیعتا پول خرج میکنند و کارهای جدیدی انجام میدهند که برای مردم ناشناخته باشد.

سوالم دربارۀ منتفی شدن انتخابات و دموکراسی توسط هوش مصنوعی را این طور هم میتوانم بپرسم: مثلا هوش مصنوعی بگوید بایدن برای تامین منافع آمریکا، صلاحیتش بیشتر از ترامپ است و دیگر نیازی به رایگیری نباشد. مثل وقتی که هوش مصنوعی در فلان بیمارستان میگوید این بیمار باید جراحی شود و نظرش دقیقتر از نظر پزشک متخصص است.

بله، چنین چیزی حداقل قابل تصور است. در واقع باید دید هدف از انتخابات چیست. اگر هدف "حکمرانی بهتر" است و آن ماشین هوش مصنوعی نظرش قابل اعتماد است، بله. در این صورت انتخابات به معنای امروزی منتفی میشود، چون هدف از انتخابات، انتخاب کاندیدایی بوده که کشور را بهتر اداره کند. اما همان طور که در پزشکی، هوش مصنوعی دستیار پزشک است، اینجا هم میتواند دستیار ملت باشد و تصمیمگیرنده نباشد. منتفی شدن انتخابات با استفاده از هوش مصنوعی، حالت انتهایی طیف است.

البته اگر انتخابات منتفی هم شود، به شکل دموکراتیک منتفی میشود. یعنی مردم رای میدهند که از این به بعد هوش مصنوعی در انتخابات ریاست جمهوری به جای آنها رای بدهد.

بله، مثلا همان طور که الان کالج الکترال در انتخابات

ریاست جمهوری آمریکا وجود دارد و در واقع، نهایتا چند فرد به نمایندگی از

مردم هر ایالت به کاندیداها رای می دهند، ممکن است مردم رای بدهند که ماشین

هوش مصنوعی نظرش را دربارۀ کاندیداها بگوید. نهایتا توافق بین اعضای جامعه

موضوع اصلی است. یک گزینه برای رایدادن هم این است که مردم به ماشین رای

بدهند. یعنی اعتمادشان را به ماشین هوش مصنوعی اعلام کنند.

اگر قرار است روزی رباتی با هوش مصنوعی به مردم بگوید به چه کسی رای دهید، آیا این امکان وجود ندارد که خود این ربات رئیس یک کشور شود؟ بویژه اینکه خشم و نفرت و انگیزههای شخصی و بدجنسیهای انسانی را ندارد و فقط بر مبنای هوشمندیاش بهترین تصمیمها را اتخاذ میکند. یعنی اعضای حکومت و اعضای پارلمان یک کشور، همگی ربات باشند!

چنین وضعیتی علیالاصول قابل تصور است ولی چند ملاحظه وجود دارد. اول اینکه همۀ ماشینهای دارای هوش مصنوعی در معرض سوگیری هستند؛ چون ما انسانها به آنها داده میدهیم و با همین کار، آنها را به جانب خاصی متمایل میکنیم.

این سوگیریها در ماشینهای دارای هوش مصنوعی یک موضوع خیلی جدی است. مثلا یک ربات ممکن است پردازشگر بسیار قدرتمندی هم باشد، اما در کل دوره فعالیتش فقط با طرفداران حزب جمهوریخواه در تعامل بوده باشد. چنین رباتی قاعدتا کاندیدای مناسبی برای ریاست جمهوری نیست.

ولی اگر این سوگیریها را بتوان مدیریت کرد و عقلانیت تام و تمام و عاری از سوگیری در یک ربات پیشرفته در کار باشد، پاسخ سوال شما میتواند مثبت باشد. مثلا شما کنترل ورودی و خروجی یک سد بزرگ یا گمرک کشور را به هوش مصنوعی میسپارید. بنابراین ممکن است سیاستگذاری و مدیریت کشور را هم کمابیش به هوش مصنوعی بسپارید. یعنی طیفی از دستیاری تا تفویض اختیار.

برای روشنتر شدن موضوع می توانم ماشینهای خودران را مثال بزنم. «خودران بودن: چند سطح دارد: ماشینی که راننده دارد و هوش مصنوعی کمکش میکند. ماشینی که هوش مصنوعی آن را میراند و راننده فقط مراقب است. ماشینی که هوش مصنوعی و راننده در آن میتوانند به جای هم کار کنند. ماشینی که کلا راننده ندارد و همۀ هدایتش با هوش مصنوعی است. چنین مدلسازیهای طیفی را میتوان در سیاست یا در حوزههای دیگر نیز در نظر داشت.

دینداران دربارۀ هوش مصنوعی موضع خاصی دارند؟ مثلا بگویند طراحی رباتی مثل سوفیا دست بردن در کار خدا و مصداق خلقت است؟

من در این مورد حداقل بحث پرسروصدایی ندیدهام، البته جستوجوی جامعی هم نکردهام. دینداران بیشتر نگران برنامۀ شبیهسازی انسان بودهاند و به مهندسی ژنتیک حساسترند. البته غیر از دینداران، خیلی از سکولارها هم نگران این موضوع بودند و نهایتا تصمیم گرفته شد که شبیهسازی انسان متوقف شود. در دهۀ 1980 چنین تصمیمی اتخاذ شد. این تصمیم حاصل یک توافق جمعی بود و صرفا خواست دینداران نبود؛ چون شبیهسازی ممکن بود هویت انسانی را زیر سوال ببرد.

موجود هوشمند را موجودی میدانند که میتواند نیازهای خودش را برآورده کند. مثلا موقع احساس خطر، فرار میکند. موجودی که هوش مصنوعی دارد، میتواند از خودش دفاع کند؟

ما دو نوع هوش مصنوعی را در نظر میگیریم: هوش مصنوعی خاص و هوش مصنوعی عمومی. هوش مصنوعی خاص یا محدود، فقط یک کارکرد خاص از هوشمندی را شبیهسازی یا بازسازی میکند. مثلا یک ماشین پردازش تصویر یا پردازش زبان طبیعی یا تشخیص پزشکی تنها یک توانمندی شناختی را از خود نشان میدهد. از چنین ماشینهایی انتظار نداریم که سایر ابعاد هوشمندی را داشته باشد. آنچه که ما الان به عنوان ماشینهای هوش مصنوعی میشناسیم، نوعا چنیناند.

اما هوش مصنوعی عمومی همۀ آنچه را که انسانها میتوانند انجام دهند،

باید انجام دهد. فعلا چنین ماشینی نداریم. یکی از کارکردهای انسان، تلاش

برای بقا یا توانمندی دفاع از خود یا تشخیص نحوه محافظت از خود است. الان

چنین چیزهایی در پروژۀ هوش مصنوعی، مسئلۀ شمارۀ یک نیستند؛ چون ما نوعا با

ماشینهایی سر و کار داریم که انسانها آنها را مدیریت میکنند. ما از این

ماشینها میخواهیم کمک کنند تا انسانها کارهای خاصی را بهتر انجام دهند.

حوزهای که موضوع محافظت از خود در آن مهم میشود، رباتهای جنگجوی مبتنی بر هوش مصنوعی است. ارتشها در کشورهای مختلف روی این تولید رباتها کار میکنند، اما اطلاعات چندانی از پیشرفتهایشان بروز نمیدهند. هدف از تولید این رباتها این است که در آینده در میدان جنگ، رباتها به جای سربازها بجنگند. این رباتها قطعا هوش مصنوعی دارند. یعنی هم بینایی ماشینی دارند، هم پردازش تصویر میکنند، هم تصمیمگیری پیشرفته دارند. باید تصمیم بگیرند چه کسی را بکشند و چه کسی را نکشند. اسیر بگیرند یا نه و البته باید بلد باشند از خودشان دفاع کنند. مانند اینکه چه سلاحی را به کار ببرند. اگر دیدند وضعیت نبرد مناسب نیست، عقبنشینی کنند. موضوع رباتهای نظامی در گفتارها مطرح است، اما اینکه چنین رباتهایی چه زمان وارد ارتشهای کشورهای گوناگون خواهند شد، مشخص نیست. این نکتۀ مد نظر شما، یعنی توان دفاع از خود در مقام یک موجود هوشمند، در عملکرد رباتهای نظامی اهمیت ویژهای خواهد داشت.

در فیلم "میانستارهای"، آن رباتی که اسمش "تارت" بود، این قابلیتها را داشت. چنان رباتی قاعدتا خیلی پیشرفتهتر از رباتهایی مثل سوفیا است. بله؟

بله، چنین قابلیتهای در رباتهای کنونی در دسترس نیست.

اگر کامپیوتر و اینترنت را منها کنیم، در حال حاضر هوش مصنوعی تاثیر چشمگیری در زندگی بشر دارد؟

تاثیرگذاری هوش مصنوعی بر زندگی بشر هنوز در ابتدای راه است. همان طور که اشاره کردم، امکانات مدلسازی و ابزار نظری انسان در این زمینه، به شکلی که الان میشناسیم، از سال 2000 به بعد توسعه پیدا کرده است. بنابراین باید گفت تازه اولش است!

هوش مصنوعی؛ همین حالا اینجاست

هوش مصنوعی؛ همین حالا اینجاست

منبع: سایت خبری RTE

طی گذشت دو ماه پس از انتشار chatGPT در نوامبر، این سایت بیش از 100 میلیون کاربر فعال به دست آورد که سریع ترین رشد تاریخ برای یک اپلکیشن آنلاین میباشد.

قابلیت های این برنامه و سایر ابزار مشابه آن فوق العاده است. آنها میتوانند خلاصه سازی کتابها و تولید تصاویر را در کسری از ثانیه انجام دهند. اما چه تاثیری ممکن است بر چگونه کار کردن ما بگذارند؟ و کدام مشاغل را تحت تاثیر قرار میدهند؟

یک تیم علمی در ایالات متحده سعی کرده است به این سوالات پاسخ دهد.

پژوهشگرانی از دانشگاه های پرینستون، نیویورک و پنسیلوانیا اقدام به بررسی این موضوع کردند که کدام مهارت های شغلی تحت تاثیر قابلیت های سیستم های هوش مصنوعی مانند chatgpt ،که به آنها مدل های زبان وسیع میگویند، قرار میگیرند.

آنها در مقاله اخیر خود نتیجه گیری کردند کارمندان پردرآمدی که نیاز به تحصیلات بالایی دارند، بیشترین تاثیر را از این نوع برنامهها میپذیرند.

پرفسور ماناو راج از دانشگاه پنسیلوانیا، یکی از نویسندگان مقاله، در گفتگو با "پرایم تایم" افزود که بخش های حقوقی و آموزشی بالاترین نمره تاثیرپذیری را داشتند. وی اظهار داشت: فکر میکنم این موضوع نشان میدهد که در این مشاغل، ارتباط و پردازش اطلاعات بسیار است. ما میدانیم که مدل های زبانی در این زمینه بسیار خوب هستند.

یکی از همکاران او، استاد رابرت سیمانز از دانشگاه نیویورک افزود: منظور ما از تحت تاثیر هوش مصنوعی بودن یک شغل، این است که شغل مربوطه به شکلی تغییر خواهد کرد که از قابلیت های هوش مصنوعی بتواند بهره مند شود اما به این معنی نیست که این شغل نابود میشود.

ChatGPT توسط شرکت OpenAI، که تحت حمایت مایکروسافت است، ایجاد شده است. قابلیتهای آن موجب تعجب و علاقه مندی کاربران سراسر جهان به هوش مصنوعی شده است. از زمان راهاندازی آن در نوامبر(2023)، گوگل، متا و مجموعهای از شرکتهای دیگر مدلهای زبانی وسیع خود را منتشر یا بهروز رسانی کردهاند.

مدل های زبانی وسیع عمدتا به منظور ایجاد ارتباط بین کلمات، مجموعه دادهها و شبکه های دیجیتالی برنامه نویسی شده اند که این فرایند توسط فرایند یادگیری عمیق (deep learning) انجام میشود. سایر مدل های مشابه نیز میتوانند روی عکسها و هنر به منظور تصویرسازی ، برنامه ریزی بشوند.

آنها میتوانند به درخواست کاربران به صورت کتبی پاسخ دهند، کدهای کامپیوتری را تولید و تصحیح و دادهها را تجزیه و تحلیل و بازسازی کنند، تصاویر و آثار هنری نزدیک به واقعیت را تولید و الگوها را تشخیص دهند و مجموعه متنوعی از سایر وظایف مبتنی بر کامپیوتر را انجام دهند.

از آنجا که پاسخها به طور مستقیم در جواب به هر درخواست هر کاربر ایجاد میشوند، مدل های تولید کننده تصاویر و متن هر دو به عنوان سیستم های هوش مصنوعی مولد (generative AI) دسته بندی میشوند.

پیشرفت های اخیر هوش مصنوعی مولد، منجر به بحث های فراوانی در باره پتانسیل آنها در ایجاد اختلال در اقتصاد و تسخیر مشاغل کارگران شده است.

آرویند کریشنا مدیرعامل شرکت IBM در مصاحبه با شبکه بلومبرگ گفته است میتواند پیش بینی کند که 30 درصد کار هایی که توسط بخش های پشتیبانی سازمانها ، مانند منابع انسانی انجام میشود ، در بازه ای پنج ساله توسط هوش مصنوعی و اتوماسیون جانشین شوند.

در ماه مارس، کارشناسانی از گلدمن سکس اذعان داشتند که دو- سوم مشاغل فعلی تا حدودی در معرض تاثیرات اتوماسیون هوش مصنوعی قرار دارند و ممکن است هوش مصنوعی مولد جانشین یک – چهارم مشاغل فعلی بشود.

علاوه بر مشاغل حوزه های آموزش و حقوق، محققان همچنین مشاغل حوزه های رسانه، بانکداری و مالی، نرم افزار و توسعه وب، مهندسی، طراحی و انتشارات را در زمره مشاغلی که تحت تاثیر هوش مصنوعی قرار میگیرند، دسته بندی کرده اند.

در این مقاله، دو رده بندی جداگانه منتشر شده است. مورد اول، تاثیر هوش مصنوعی مولد زبان (مانند chatgpt و مورد دوم ، تاثیر هوش مصنوعی مولد تصاویر (مانند MidJourney و Dall-E) را بر مشاغل بررسی میکند.

مشاغلی که بیشترین تاثیرپذیری از هوش مصنوعی مولد زبان را داشتند معلمان رشته های ادبیات، زبان انگلیسی و زبان های خارجی بودند. در سمت دیگر، طراحان داخلی، معمارها و مهندسان شیمی بیشترین تاثیرپذیری را از هوش مصنوعی مولد تصاویر داشتند.

کمترین میزان تاثیر پذیری نیز مربوط به کارگران نساجی، بنّا ها، مربیان تناسب اندام و ماساژ درمانگر بود.

در مقاله آمده است: اثرات هوش مصنوعی مولد احتمالا به طور نسبتاً سریع ظاهر خواهد شد.

دکتر شان اوهیگارتی، مدیر مرکز مطالعات ریسک وجودی در دانشگاه کمبریج با این نظر موافق است. وی میافزاید: من فکر میکنم این پدیده صرفا از یک محصول نادر تکنولوژیک به چیزی تبدیل خواهد شد که میلیونها انسان را بسیار سریع تحت تاثیر قرار خواهد داد. همچنین از سختی های بسیاری از کارهایی که وقت گیر هستند خواهد کاست. اما باید توجه داشت که این تحول بدون توجه به بخش بزرگی از افراد جامعه جهانی صورت میگیرد. به عنوان مثال، کارمندان دورکار هندی که مشغول حاشیه نویسی دادهها یا جواب دادن تلفنها در مراکز تماس هستند ، ممکن است بسیار زود کار خود را از دست بدهند. شکی نیست که مشاغل زیادی به کمک هوش مصنوعی به وجود خواهند آمد، اما آنها لزوما به افرادی که شغل خود را از دست داده اند، اختصاص نخواهد یافت.

دکتر اوهیگارتی یکی از امضا کنندگان نامه سرگشاده ای است که اخیرا توسط موسسه "آینده زندگی" دانشگاه آکسفورد منتشر شده است. در این نامه، شش ماه توقف توسعه برخی از سیستم های هوش مصنوعی خاص درخواست شده است.

وی در مصاحبه با پرایم تایم میافزاید: منطقی است که حرکت را آهسته تر کنیم تا زمان کافی برای شنیدن صدای افراد در سراسر جهان، صنایع و مشاغل متاثر را، داشته باشیم. مردم باید در نوع توسعه و انتشار هوش مصنوعی سهیم باشند.

پروفسور راج معتقد است که سیاست گذاران و سیاستمداران باید به اثرات احتمالی هوش مصنوعی بر اقتصاد توجه کنند.

وی معتقد است : حتی اگر این مسئله یک خیر جمعی باشد، عده از مردم در کار خود آشفتگی و دغدغه را تجربه خواهند کرد. بعضی شغلها به طور کامل حذف خواهند شد و احتمالا نیاز به میزانی از بازآموزی و انطباق خواهد بود، اما من خوش بین هستم. من فکر میکنم به سبب یادگیری چگونگی استفاده از این تکنولوژی ها، مشاغل و وظایف جدیدی به وجود خواهد آمد.

دکتر سیمانس نیز نظر مشابهی دارد. وی میگوید: نگران این نباشید که هوش مصنوعی شغلتان را از شما بگیرد. احتمال آن بسیار کم است. اما به احتمال زیاد هوش مصنوعی کار شما را تغییر خواهد داد. پس جهت آمادگی داشتن برای این تغییر، خودتان شخصا شروع به استفاده از آنها بکنید. بسیار از پژوهشگران و تحلیل گرانی که در چند ماه اخیر با پرایم تایم صحبت کرده اند به طور کلی هم نظرند که ابزار هوش مصنوعی ، هم اکنون ویژگی های تکنولوژی ای را به نمایش میگذارد که از آن به عنوان تکنولوژی های همه کاره (general purpose technologies) یاد میشود.

تکنولوژی های همه کاره ابزار یا سیستم هایی هستند که نه فقط صنایع ، بلکه اقتصادها و جوامع را نیز دچار تغییر میکنند. مثال های پیشینِ تکنولوژی های همه کاره در تاریخ بشری شامل: موتور بخار، ماشین چاپ و رایانه شخصی میباشند.

پرفسور پاتریشیا مگوایر از دانشگاه دوبلین میگوید: اتفاقی که میافتد این است که افرادی که از هوش مصنوعی استفاده میکنند جایگزین افرادی میشوند که از آن استفاده نمی کنند. ما نمی توانیم در این مسیر کسی را جا بگذاریم. در نتیجه ، نیاز داریم که آموزش دهیم ، و به نظر من این آموزش باید از سطوح ابتدایی مدارس آغاز شود. بری اوسولیوان، پرفسور علوم کامپیوتر دانشگاه کورک نیز میگوید: غیرممکن است که بتوانیم حدس بزنیم چه مشاغلی به واسطه استفاده همگانی از ابزار هوش مصنوعی پدید خواهد آمد. ما صرفا میتوانیم برخی را حدس بزنیم، اما واقعیت این است که ما حتی نمی دانیم جهان پنج سال دیگر چگونه خواهد بود.

بزودی؛ آمدن پلتفرمهای هوش مصنوعی برای کسبوکارها

دیجیاتو نوشت: شرکت IBM از پلتفرمی بهنام Watsonx رونمایی کرده است که به شرکتها کمک میکند تا مدلهای هوش مصنوعی خود را بسازند.

ارزیابیهایی درباره برخی پیآوردهای هوش مصنوعی برای انسانها

گلدمن

ساکس، شرکت سرمایهگذاری آمریکایی، در یادداشتی تحلیلی از احتمال اثرگذاری

هوش مصنوعی بر ۳۰۰ میلیون شغل خبر داده است. مدیران گلدمن ساکس در

یادداشتی خطاببه سرمایهگذاران نوشتهاند اگر وعدههای مربوطبه هوش

مصنوعی مولد رنگ حقیقت به خود بگیرند، «اختلال قابلتوجه» در بازار نیروی

کار رخ خواهد داد. به گفتهی گلدمن ساکس، دوسوم از شغلهای آمریکا در معرض

تأثیرپذیری از سیستمهای خودکار مبتنیبر هوش مصنوعی هستند و وظایف کاری

بالغبر ۵۰ درصد از این شغلها را میتوان با هوش مصنوعی جایگزین کرد.

گلدمن ساکس، شرکت سرمایهگذاری آمریکایی، در یادداشتی تحلیلی از احتمال اثرگذاری هوش مصنوعی بر ۳۰۰ میلیون شغل خبر داده است.

پیشرفتهای اخیر در حوزهی هوش مصنوعی باعث شده مردم نگران امنیت شغلی خود شوند و آنطور که بهنظر میرسد، این نگرانی کاملا درست است. گلدمن ساکس، شرکت سرمایهگذاری بزرگ آمریکایی، در گزارشی جدید گفته است که فناوری هوش مصنوعی مولد بالغبر ۳۰۰ میلیون شغل را تحت تأثیر قرار میدهد.

مدیران گلدمن ساکس در یادداشتی خطاببه سرمایهگذاران نوشتهاند اگر وعدههای مربوطبه هوش مصنوعی مولد رنگ حقیقت به خود بگیرند، «اختلال قابلتوجه» در بازار نیروی کار رخ خواهد داد. به گفتهی گلدمن ساکس، دوسوم از شغلهای آمریکا در معرض تأثیرپذیری از سیستمهای خودکار مبتنیبر هوش مصنوعی هستند و وظایف کاری بالغبر ۵۰ درصد از این شغلها را میتوان با هوش مصنوعی جایگزین کرد.

تحلیلگران معتقدند با وجود آثار گستردهی هوش مصنوعی بر بازار نیروی کار، اکثر شغلها و صنایع تا حدی در معرض اتوماسیون قرار میگیرند، بههمیندلیل پیشبینی میشود که هوش مصنوعی بهجای جایگزینی، مکمل آنها شود.

ممکن است در نهایت هفت درصد از شغلهای آمریکا بهطور کامل با هوش مصنوعی جایگزین شوند، ۶۳ درصد از هوش مصنوعی بهعنوان مکمل بهره بگیرند و ۳۰ درصد از هوش مصنوعی متأثر نشوند.

گلدمن ساکس میگوید هوش مصنوعی مولد که توانایی تولید انواع محتوا را دارد، نمایانگر «پیشرفتی عظیم با آثار احتمالا بزرگ بر اقتصاد کلان» است. استفادهی گسترده از هوش مصنوعی ممکن است ارزش نهایی کالاها و خدمات سراسر دنیا را در ۱۰ سال آینده بهمیزان هفت درصد افزایش دهد.

فناوری هوش مصنوعی مولد از زمان انتشار عمومی ChatGPT در اواخر سال گذشتهی میلادی، بهشدت در معرض توجه قرار گرفته است. ChatGPT چتباتی قدرتمند است که میتواند متن و شعر و کد بنویسد. مایکروسافت از فناوری استفادهشده در ChatGPT برای تقویت برخی از سرویسهایش نظیر موتور جستوجوی بینگ استفاده کرده است.

رشد انفجاری ChatGPT باعث شده است شماری از بزرگترین شرکتهای حوزهی فناوری سرمایهگذاری سنگینی در این حوزه انجام دهند. مایکروسافت ۱۰ میلیارد دلار در شرکت خالق ChatGPT سرمایهگذاری کرد و گوگل پروژههای هوش مصنوعی را در بالاترین اولویت قرار داد.

گلدمن ساکس در یادداشت جدیدش به مطالعهای اشاره کرد که نشان میدهد ۶۰ درصد از شغلهای امروز در سال ۱۹۴۰ وجود نداشتند. این شرکت میگوید یکچهارم از تمامی وظایف کاری انجامشده در ایالات متحده و اروپا ممکن است به دست هوش مصنوعی بیفتد.

در آمریکا، مشاغل اداری و حقوقی و معماری و مهندسی در بیشترین خطر اتوماسیون هستند. شغلهایی که کمتر در معرض هوش مصنوعی قرار میگیرند شامل مواردی مثل نظافت، نصب و تعمیر محصولات و کارهای ساختمانی است.

منبع: زومیت

انسانها بهدست هوشمصنوعی حذف میشوند؟

جفری هینتون، دانشمند کامپیوتر انگلیسی، بیشتر به عنوان «پدرخوانده هوش مصنوعی» شناخته میشود. کار اصلی او بر روی شبکههای عصبی با تقلید از فرآیندهای شناخت انسان، پایههای مدلهای یادگیری ماشین امروزی را شکل داد. او خلق این فناوری را به اختراع برق یا چرخ تشبیه کرده است. او که در گوگل و دانشگاه تورنتو کار میکند، میگوید توسعه هوش جامع مصنوعی سریعتر از آنچه تصورش را میکنید، درحال پیشروی است.

هنوز برای کنترل هوش مصنوعی دیر نیست

هوش جامع مصنوعی یا AGI به سیستمی اشاره میکند که بتواند مانند انسانها همه فعالیتهای ذهنی را در بر بگیرد. چنین سیستمی هنوز بهوجود نیامده است، اما با ظهور ابزارهای جدید هوش مصنوعی از جمله ChatGPT، این بحث دوباره داغ شده است. هینتون باور دارد که کامپیوترها درنهایت میتوانند قابلیت تفکر و ایدهپردازی پیدا کنند تا خودشان را بهبود ببخشند.

به بیان دیگر AGI اصطلاحی است که هوش مصنوعی بالقوهای را توصیف میکند که میتواند سطوح هوش انسانی یا فوقانسانی را نشان دهد. یک AGI به جای اینکه آشکارا تخصصی باشد، قادر به یادگیری و فکر کردن به تنهایی برای حل طیف وسیعی از مشکلات است.

در حال حاضر، نشانههای AGI اغلب برای تقویت قابلیتهای مدلهای فعلی مورد استفاده قرار میگیرد. اما صرف نظر از غوغای صنعت که از ورود آن استقبال میکند یا اینکه واقعاً چه مدت ممکن است تا AGI برای ما طلوع کند، هینتون میگوید که اکنون باید به دقت عواقب آن را در نظر بگیریم که ممکن است شامل یک مسئله جزئی در تلاش برای نابود کردن بشریت باشد.

همچنین، بر اساس دیدگاه هینتون، بشریت هنوز اندکی فضای تنفسی دارد تا اینکه اوضاع کاملاً از کنترل خارج شود، زیرا مدلهای کنونی در دسترس عموم، جای کار بیشتری دارند. از سوی دیگر نیز «سم آلتمن»، مدیرعامل OpenAI هم چندی پیش درباره توسعه ChatGPT و هوش مصنوعی همچنین در این باره گفته بود: «باید در این مسیر مراقب باشیم. فکر میکنم مردم باید خوشحال باشند که ما کمی در این باره واهمه داریم.»

هینتون نیز پیشبینی میکند که «ما به سمت سیستمهایی حرکت میکنیم که میتوانند دیدگاههای مختلف جهان را درک کنند که ترسناک است، زیرا به این معنی است که هر کسی که از هوش مصنوعی بهره میبرد میتواند از آن استفاده کند و جهانبینی ویژه خود را ایجاد کند.» با این حال، هینتون معتقد است که مسئله واقعی در افق این است که فناوری هوش مصنوعی که ما در حال حاضر داریم یا «AGI» میتواند در انحصار دولتها و شرکتهای تشنه قدرت قرار گیرد که شاید نتایج مثبتی به دنبال نداشته باشد.

منبع: هیل

ترجمه: فرارو

آوی لوب، رئیس پروژه گالیله و مدیر موسس

ابتکار عمل سیاه چاله دانشگاه هاروارد و مدیر موسسه تئوری و محاسبات در

مرکز اخترفیزیک هاروارد -اسمیتسونین و رئیس سابق بخش نجوم در دانشگاه

هاروارد میباشد. او عضو سابق شورای مشاوران رئیس جمهور امریکا و رئیس سابق

هیئت فیزیک و نجوم آکادمیهای ملی بوده است.

پروفسور لوب نویسنده

کتاب "فراز زمینی: اولین نشانه حیات هوشمند فراتر از زمین" است که از

پرفروشترین کتابها بوده است. کتاب جدید او با عنوان "بین ستارهای" در

آگوست سال ۲۰۲۳ میلادی چاپ خواهد شد. پروژه گالیله تحت هدایت او به این

موضوع اختصاص دارد که انسانها دیگر نمیتوانند وجود احتمالی تمدنهای

فناوری فرازمینی را نادیده بگیرند و علم نباید به طور جزمی توضیحات بالقوه

فرازمینی را به دلیل انگ اجتماعی رد کند. برخلاف سایر پروژههای مشابه هدف

پروژه گالیله جستجوی اجسام فیزیکی و نه سیگنالهای الکترومغناطیسی مرتبط با

تجهیزات تکنولوژیکی فرازمینی است.

معنای انسان بودن اغلب با ویژگیهای متافیزیکی مانند "آگاه بودن"، داشتن "روح" و اعمال "اراده آزاد" همراه است. با این وجود، اگر یک سیستم هوش مصنوعی مانند نسخه بهبود یافته چت جی پی تی (Chat GPT) دارای ویژگیهای مشابهی در بازی تقلید "آلن تورینگ" ریاضیدان باشد آن گاه چیز جدیدی در مورد واقعیت خواهیم آموخت.

بدون فرصت گفتگو برای تمایز انسان از ماشین آشکار خواهد شد که کیفیتهای متافیزیکی پدیدههای نوظهوری هستند، زیرا ساختار پیچیده سیلیکون در رایانه میتواند ساختار پیچیدهای از مولکولهای آلی در مغز انسان را تقلید کند.

به عبارت دیگر، در آن صورت هیچ تفاوت اساسیای بین تعاملات "من – تو" و "من – آن" که یک قرن پیش توسط "مارتین بوبر" فیلسوف تعریف شده بود وجود نخواهد داشت. در آن صورت هر دو معادل تعاملات "من – هوش مصنوعی" و "هوش مصنوعی – هوش مصنوعی" خواهند بود، زیرا هوش مصنوعی صرفا از دنیای مادی ساخته شده است.

این بدان معناست که وقتی بدن ما میمیرد کل هویت ما میمیرد. به عبارت دیگر، مرگ مانند جدا کردن یک سیستم هوش مصنوعی از منبع تغذیه آن است. با این وجود، یک خبر خوب نیز وجود دارد. اگر یک سیستم هوش مصنوعی برای تقلید از ذهن ما ساخته شده باشد میتواند پس از مرگ مان به تعامل با عزیزان مان ادامه دهد. اگر پیشرفتهای آینده در زیست شناسی این امکان را فراهم سازد که بدن مان را ترمیم کنیم تا از پوسیدگی جلوگیری شود ما میتوانیم برای همیشه زندگی کنیم. اگر بتوانیم بدن خود را در دنیای واقعی که در حین زندگی ما را احاطه کرده است زنده کنیم چرا رویای بقای "روح" خود را در دنیای بعدی داشته باشیم؟

این درک هشیارانه در مورد مادی گرایی یک مزیت اضافی در آموزش فروتنی به ما دارد. به ارث بردن بدن مان از والدین مانند گرفتن خودرو از یک نمایندگی است. ما صرفا میتوانیم به نحوه استفاده از آن افتخار کنیم و نه به تواناییهای آن خودرو. هیچ مبنایی برای افتخار کردن به آی کیو یا ضریب هوشی مان وجود ندارد همان گونه که افتخار کردن به تعداد دور در دقیقهای که موتور خودروی خریداری شده مان نشان میدهد امری منطقی نیست.

تنها قضاوت ارزشی باید بر اساس این باشد که آیا انسانها تواناییهای خود را برای ترویج خیر یا شر به کار میگیرند؟ مشابه این که آیا افراد انرژی هستهای را برای منافع یا سرنوشت جامعه مهار میکنند؟

با در نظر گرفتن مرگ قریب الوقوع مان وجود ما شکلی گذرا از ماده است. با این وجود، اگر اصول راهنمای مان حفظ شود میتواند مهم باشد.

ارزش آن را دارد که بررسیهای علمی در این راستا صورت گیرند: اگر بشریت به جای صرف ۲ تریلیون دلار در سال برای هزینههای نظامی هزینه برای کاوش در فضا را انتخاب میکرد طول عمر بهتری داشتیم. همین بودجه به ما این امکان را میدهد که ظرف مدت کمتر از یک قرن به هر ستاره در کهکشان راه شیری یک کاوشگر بفرستیم که افزایشی یک میلیاردی در مقایسه با نرخ فعلی که با ارسال پنج کاوشگر بین ستارهای در طول پنج دهه از وویجر ۱ و ۲ گرفته تا پایونیر ۱۰ و ۱۱ و نیوهورایزنز نشان داده شده است.

اکثر ستارگان خورشید مانند میلیاردها سال پیش از خورشید شکل گرفته اند یک تاخیر زمانی بسیار بیشتر از زمانی که موشکهای شیمیایی برای عبور از دیسک راه شیری نیاز دارند. اگر تنها یکی از دهها میلیارد منظومه زمین - خورشید در کهکشان راه شیری باعث ایجاد یک تمدن فناوری صلح آمیز فضاپیمایی شود و اگر آن تمدن کاوشگرهایی را با هزینه سالانه ۲ تریلیون دلار به مدت یک میلیون سال به فضا پرتاب کند در آن صورت ۱۰۰۰۰ شئی از این تمدن دیدنی در منظومه شمسی وجود خواهد داشت.

دستگاههای کاربردی "بقای شایستهترین ها" را در فرآیند انتخاب داروینی بین ستارهای دنبال میکنند که ممکن است همان گونه که ریاضیدانانی، چون "جان فون نویمان" و "فریمن دایسون" پیش بینی کرده اند خود همانند سازی تکنولوژیکی باشد.

ماشینهای صلحجو احتمالا با مدت زمانی طولانیتر زنده میمانند، زیرا در مقایسه با انواع تهاجمی اغلب توسط درگیریهای فیزیکی آسیب نمیبینند. پیشرفت علمی آن را از زنجیره نفس انسانی رها خواهد ساخت که ترجیح میدهد وجود موجودات ذی شعور فرازمینی را ادعایی خارق العاده فرض کند.

دستگاههای بینستارهای کاربردی ممکن است حاوی مغزهای هوش مصنوعی باشند که فرستندههای خود را بازتاب میدهند. این سیستمهای هوش مصنوعی در تمثیل افلاطون از غار که در حدود ۳۸۰ قبل از میلاد مسیح در جمهوری نوشته شده است قرار میگیرند.

در این گفتگوی باستانی بین سقراط و برادر افلاطون آن فیلسوف یونانی گروهی از مردم را توصیف میکند که در طول زندگی خود به دیوار غار بسته شده اند مشابه روشی که ما توسط گرانش در سطح زمین محدود شده ایم. زندانیان سایههایی را تماشا میکنند که بر روی دیوار خالی از اشیا دیده میشوند. آنان هیچ گاه پشت سرشان را نگاه نکردند و پشت شان آتشی روشن است و در جلوی آتش مجسمههایی قرار دارند که هنگامی که حرکت میکنند سایه ٔشان بر دیوار رو به رو میافتد. این استعاره برای اوموآموا نخستین جرم میان ستارهای شناخته شدهای که مسیر حرکت آن از منظومه خورشیدی میگذرد و توسط خورشید روشن میشود کافیست. به گفته سقراط در این گفتگو فیلسوف به دنبال درک سطوح بالاتر واقعیت است. معادل مدرن آن دانشمندی است قصد دارد ماهیت اجرام بین ستارهای را دریابد همانند کاری که من در پروژه گالیله هاروارد انجام میدهم.

در عین حال، تمثیل افلاطون ادعا میکند که سایر زندانیان غار حتی تمایلی به ترک زندان خود ندارند، زیرا آنان زندگی بهتری را نمیشناسند. این نشان دهنده واکنش فعلی شکاکان به جستجوی علمی برای کشف اشیاء تکنولوژیکی فرازمینی است.

از آنجایی که علم و فناوری مدرن ما تنها یک قرن قدمت دارد این احتمال وجود دارد که کاوشگرهای هوش مصنوعی فرازمینی بسیار پیشرفتهتر از گجتهایی (یا ابزارک به وسایل الکترونیکی یا مکانیکی کوچکی گفته میشود که برای کاربردهای خاصی طراحی شده اند و به آسانتر شدن زندگی کمک میکنند) باشند که امروز میتوانیم بسازیم. برخورد ما با آن یک تجربه یادگیری خواهد بود و با احساس فروتنی مناسب به ما این امکان را میدهد که جهشی کوانتومی به سمت آینده تکنولوژیکی خود داشته باشیم.

علاقه دولت ایالات متحده به پدیدههای هوایی ناشناس (UAP) به عنوان یک موضوع امنیت ملی علاقه علمی به اجرام فرازمینی را تحسین میکند. با ساقط کردن بالنها یا پهپادهای کشورهای متخاصم دولت از شلوغی اشیاء ساخته شده توسط انسان در آسمان ما میکاهد و بررسی این که آیا کاوشگرهای فرازمینی در آنجا وجود دارد یا خیر را برای دانشمندان آسانتر میکند.

در مجموع، با فرض اینکه واقعیت فیزیکی شناخته شده تمام انواع هوش را به تصویر میکشد ما باید بتوانیم کاوشگرهای هوش مصنوعی فرازمینی را با استفاده از آشکارسازها بر اساس فیزیکی که میشناسیم شناسایی نماییم. دادههای پروژه گالیله که ما آپلود و تجزیه و تحلیل آن را آغاز کرده ایم در سالیان آینده در دسترس عموم قرار خواهد گرفت. منتظر نتایج باشید، زیرا ما "تمثیل غار" افلاطون را به واقعیت تبدیل میکنیم.