رایورز - مطابق اخبار رسانهها، به تازگی یک طرح ویژه و جدید برای اینترنت اشیاء ارائه شده است که بر اساس آن قرار است تا پردازش اصلی بهجای انجام شدن در یک واحد جداگانه، به حافظه سیستمهای کامپیوتری انتقال یابد و به این ترتیب سرعت عملکرد دستگاههای کوچک بهمراتب بالاتر خواهد رفت.

به گزارش وبسایت خبری تحلیلی the inquirer، شرکت بوفینز (Boffins) بهتازگی طرح ویژهای را ارائه کرده است که در صورت عملیاتی شدن، میتواند موجب شکلگیری یک انقلاب در صنایع کامپیوتری شود.

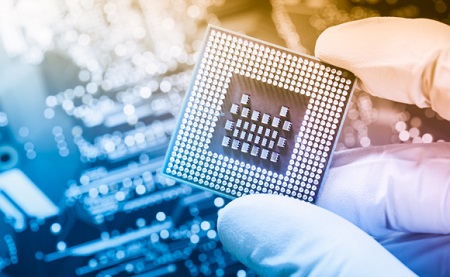

بر اساس این طرح که توسط تیمی متشکل از دانشمندان سنگاپوری و آلمانی ارائه شده است قرار است تا بار پردازشی سیستمهای کامپیوتری دیگر بر دوش واحد پردازش مرکزی یا همان سی.پی.یو نباشد.

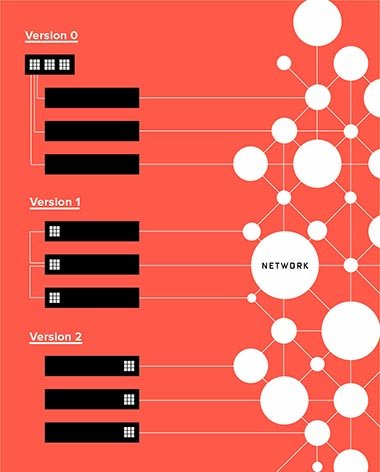

بر اساس این طرح انقلابی میتوان از حافظه رم (RAM) بهعنوان محلی برای پردازش دادههای کامپیوتری استفاده کرد و به این ترتیب ممکن است بهزودی دیگر رم، تنها بهعنوان حافظه جانبی پردازشی بهحساب نیامده بلکه با ارتقاء شغلی بسیار ویژهای به هسته پردازشی سیستمهای کامپیوتری بدل گردد.

گفتنی است مطابق جزئیات این طرح، این سیستم بر روی رمهای معمولی موجود در بازار قابل اعمال نیست و برای این کار نسل جدیدی از حافظهها در حال طراحی است که البته واحدهای طراحی سختافزار مختلفی بر روی ساخت آن کار میکنند.

این نسل جدید از رمها با نام ReRAM شناخته میشوند که نسلی از رم هستند که برخلاف سایر نمونههای فعلی موجود در جهان، حافظه موقت بهحساب نمیآیند.

در صورت تحقق این پروژه میتوان انتظار داشت که سرعت افزایش و هزینه و مصرف انرژی کامپیوترها بهصورت چشمگیری کاهش یابد و در عین حال از نظر اندازه نیز شاهد کوچکتر شدن کامپیوترها باشیم که همگی این مؤلفهها از نیازهای اصلی برای پروژه اینترنت اشیاء بهحساب میآیند.