واحد مشترک کمکی پژوهش و مهندسی «هوش یار-تواندار» (HT-CSURE)

Hooshyar-Tavandar Common Subsidiary Unit for Research & Engineering

واحد مشترک کمکی پژوهش و مهندسی «هوش یار-تواندار» (HT-CSURE)

Hooshyar-Tavandar Common Subsidiary Unit for Research & Engineeringآشنایی با موتورهای جستجوی امن اینترنتی

با تخصصی شدن امور و نیاز تقریبا روزانه به استفاده از اینترنت به عنوان یک منبع مهم دریافت اطلاعات ، نقش موتورهای جستجوی اینترنتی بیش از پیش اهمیت یافته است.

در این میان و همزمان با هجوم میلیارد ها کاربر از سراسر جهان به موتورهای جستجوی اینترنتی، دغدغه بسیاری از کاربران ، در امن بودن و محفوظ ماندن اطلاعات شخصی مربوط به آنهاست.

با وجودی که "رد گم کردن " در فضای اینترنت کاری تقریبا محال است اما هستند موتورهای جستجوی به نسبت امنی که به کاربران خود تضمین داده اند آدرس "آی پی " آنها و دیگر مشخصات جستجوی آنها را در سرور خود ذخیره نمی کنند و این گونه به کاربران تضمین می دهند نتایج جستجوی آنها در مورد موضوعات مختلف در سرورهای این موتور های جستجو ذخیره نمی شود.

در واقع این موتورهای جستجو نقش رابط را در برقرای ارتباط کاربر با "ابر موتورهای" جستجوی اینترنت بازی می کنند و به آنها تضمین می دهند که دست آنها را گرفته و به فضای داخل وب می برند با این تفاوت که ردپای آنها پس از استفاده از اینترنت در جایی نمی ماند.

برای دانستن اهمیت جستجوی اینترنتی فقط کافی است به یک آمار از بزرگ ترین موتور جستجوی اینترنتی جهان اشاره شود.

موتور جستجوی " گوگل " که بزرگ ترین موتور جستجوی اینترنتی جهان است در هر ثانیه 2.3 میلیون جستجوی مختلف را در سرورهای خود ذخیره می کند.

یعنی در هر ثانیه به طور همزمان 2.3 میلیون کاربر از سرتاسر جهان با زدن کلید واژه هایی در این "ابرموتور جستجو" به دنبال دریافت اطلاعات مختلف از سوژه های مورد نظر خود هستند.

اما مطالبی را که کاربران در گوگل مورد جستجو قرار می دهند با آدرس دقیق "آی پی " های کاربران در سرور این موتور جستجو ثبت و ضبط می شود، مگر اینکه کاربران از امکان جستجوی محرمانه این موتور جستجو استفاده کنند، اما بسیاری از کاربران از وجود چنین امکانی در این موتور جستجو اطلاعی ندارند.

بر اساس تحقیقی که در سال 2012 از سوی شرکت گوگل انجام شده است بیش از نیمی از کاربران اینترنت از وجود موتور ها یا امکانی به نام "جستجوی ایمن" اطلاعی ندارند.

با این حال از نظر بسیاری از کارشناسان وب، استفاده از سرویس های محرمانگی و جستجوی ایمن در گوگل تاثیر چندانی نیز ندارد و به هر صورت اطلاعات مربوط به آی پی آدرس کاربر و کلمات و واژه هایی که از سوی او جستجو می شود در موتور جستجو ثبت و ضبط می شود.

در واقع از نظر این کارشناسان این امکانات تنها کامپیوتر خود کاربر را از ذخیره اطلاعات مربوط به جستجوی اینترنتی محروم می کند و در سوی دیگر قضیه یعنی سرور بزرگ موتور جستجویی که از آن استفاده می شود، اطلاعات ثبت و ضبط می شود.

به عبارت دیگر این امکانات موتورهای جستجو همچون گوگل ، مانع فاش شدن دو اطلاعات مهم از کاربر نمی شود: 1- آدرس آی پی کاربر اینترنتی که از موتور جستجو استفاده می کند، ثبت می شود و 2- ثبت شدن فعالیت ها و جستجوهای اینترنتی کاربر در سرور شرکتی که از آن مشترک اینترنت شده است.

حال با این مقدمه بد نیست چند موتور جستجوی ایمن اینترنتی به صورت خلاصه وار مورد اشاره قرار گیرد. لازم به ذکر است که این موتورهای جستجوی اینترنتی به کاربران این اطمینان را داده اند که اطلاعات مربوط به آی پی و جستجوهای مختلف کاربران از موتور جستجوی آنها ثبت و ضبط و قابل رد یابی نیست :

1- موتور جستجوی " داک داک گو " (DuckDuckGo ) : این موتور جستجوی وب به کاربرانی که از آن استفاده می کنند اطمینان داده است که انها را ردگیری نمی کند. داک داک گو از سپتامبر 2008 و همزمان با بحث های مروبط به حریم خصوصی کاربران اینترنت راه اندازی و فعال شده است. این موتور جستجو در صفحهٔ "سیاست حریم خصوصی" خود به کاربرانش تضمین داده است که هیچگونه اطلاعات شخصی آنها را جمعآوری و به اشتراک نمیگذارد.

2- موتور جستجوی "Ixquick " : این موتور جستجو نیز به کاربران وعده پاک شدن رد پای آنها را داده است . تفاوت این موتور جستجو در باهوش تر عمل کردن آن در مقایسه با دیگر موتورهای جستجوست. دیگر تفاوت این موتور جستجو در سرعت بالای آن است. همچنین برخلاف سایر موتور جستجو ها، جستجو در Ixquick با 14 موتور جستجو بههمراه رتبه بندی میزانارتباط مطالب صورتمیگیرد و نتایججستجو در هر یک از موتورهایجستجو بهطور جداگانه نشانداده میشود.

نکته مهم در این موتور جستجو این است که این موتور از امکان جستجو از دیگر ابر موتورهای جستجوی جهان (همچون گوگل و یاهو و ...) استفاده می کند اما اطلاعات کاربر را پنهان نگه می دارد و در واقع استفاده از این موتور جستجو یک راه میانبر و یک طریق واسط برای دور زدن امکان ثبت و ضبط اطلاعات کاربر در سرورهای موتور های جستجوی بزرگ است.

همچنین " Ixquick " از معدود ابر موتورهایی است که امکان انجام جستجوی پیشرفته را در اختیار کاربران قرار میدهد و از امکانات و تسهیلات هر یک از موتورهایجستجو برایانجام جستجوهای پیشرفته آگاه میباشد. کاربری که از این موتور جستجو استفاده می کند بدون نام می ماند . در صفحه " سیاست حریم خصوصی" سایت اصلی این موتور جستجو جمله ای آمده است: یگانه راه حفاظت از حریم خصوصی کاربران پاک کردن و ذخیره نکردن اطلاعات مربوط به کابران است.

3- موتور جستجوی " meta ger" : این موتور جستجوی اینترنتی حاصل همکاری دانشگاه هانوفر آلمان با سازمان های غیر دولتی دسترسی آزاد به اطلاعات در این کشور است. این موتور جستجو نیز همچون موتور جستجوی " Ixquick " ایجاد امکان استفاده رمزگذاری شده از دیگر موتورهای جستجوی بزرگ اینترنت بدون ردپا است.

4- موتور جستجوی " yippy" : این موتور جستجو به منظور حفاظت از کودکان و نوجوانان در برابر محتوای سایت های " پورنوگرافی" و یا قمار تاسیس شده است. در صفحه سیاست سایت اصلی این موتور جستجو آمده است : ما محیطی امن بدون وجود امکان پیگیری و ردیابی را به کاربران خود تضمین می دهیم." با این حال امکان عدم ردیابی و ثبت نشدن اطلاعات شخصی کاربران در سرورهای این موتور جستجو تنها برای کاربران داخل ایالات متحده است.

بدیهی است که موتورهای جستجوی جهانی و محلی لیست بلندبالایی دارد و اگر همه آنها لیست شود چند صفحه می شود.

آنچه گوگل از وب گردی شما میداند

آنچه گوگل از وب گردی شما میداند

آیا تا به حال به این موضوع فکر کرده اید که گوگل تا چه حد در مورد شما و هویت شما میداند؟ خوب برای شروع لازم است این را بدانید که گوگل میداند شما چند سال دارید، کجا زندگی میکنید و از کجا به اینترنت متصل میشوید و اساسا به چه چیزهایی علاقمند هستید. اما این همه آن چیزی که گوگل از شما میداند نیست.

به گزارش «تابناک» دیگر همه ما تسلیم این موضوع شده ایم که تکنولوژی که به شکل روزانه در حال استفاده از آن هستیم ما را رصد کرده و تمامی حرکت های ما را ثبت و ضبط میکند. گوشی هوشمند شما هر جایی که بوده اید را میداند، نقشه های گوگل همواره در حال رصد کردن موقعیت جغرافیایی شما است و شاید جالب باشد که بدانید فیسبوک پروفایل کاملی از همه ویژگیهای شخصیتی کاربرانش دست و پا کرده است.

اما تنها برای آن که بفهمید گوگل تا چه حد در مورد شما و وضعیت شما اطلاعات دارد کافی است این چند قدم ساده را بردارید:

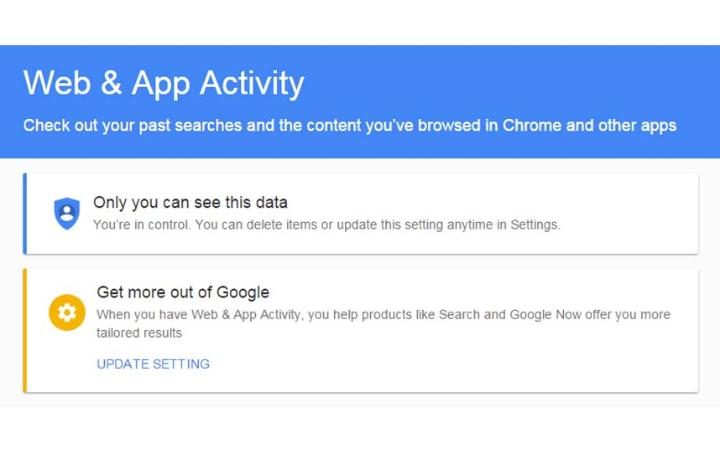

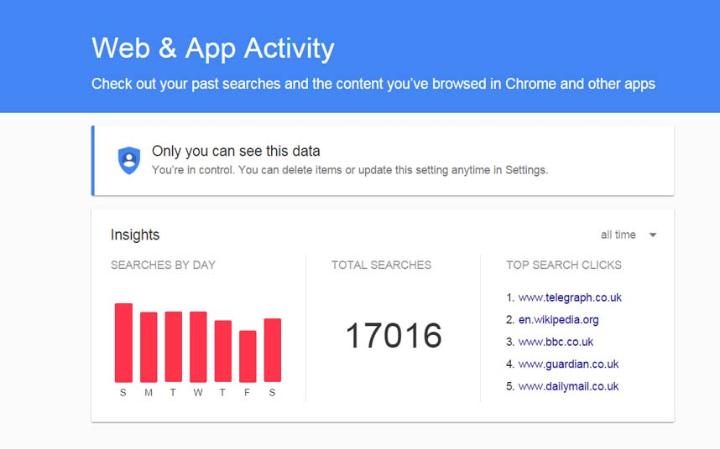

1 - ابتدا وارد حساب کاربری گوگل خود شوید و سپس به آدرس history.google.com/history بروید. در این قسمت به خوبی میتوانید متوجه شوید که هرگاه بر روی دستگاه و مرورگر خود به حساب کاربری گوگل وارد شده باشید، گوگل تمامی تاریخچه مربوط به وب گردی شما را ذخیره کرده است. گوگل به این ترتیب میتواند به سادگی عادات مربوط به وب گردی شما را تشخیص دهد.

2 - در گوشه سمت راست روی گزینه Last Week کلیک کنید و آن را به All Time تغییر دهید.

3 - میتوانید این گزینه را بر روی ماه اخیر یا سال اخیر نیز تنظیم کنید تا تصویر دقیق تری از اطلاعاتی که گوگل از شما دارد به دست آورید.

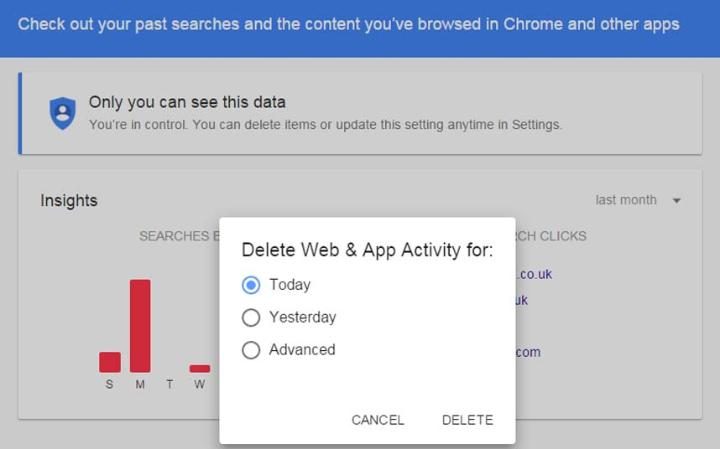

4 - شما میتوانید همه این اطلاعات را پاکسازی کنید. برای این کار کافی است بر روی منوی که با سه نقطه در بالای صفحه قرار دارد کلیک کنید و سپس گزینه Delete Options را انتخاب کنید. در پنجره ای که باز میشود در صورتی که گزینه Advanced را انتخاب کنید میتوانید تاریخچه کامل وب گردی خود را پاکسازی کنید.

نکاتی برای کسب موفقیت بیشتر و سریعتر در حرفه برنامه نویسی

نکاتی برای کسب موفقیت بیشتر و سریعتر در حرفه برنامه نویسی

آغاز حرفه برنامهنویسی میتواند چالشبرانگیز باشد. میتوان با اطمینان گفت که تقریبا هر برنامهنویس تازه کاری در آغاز کار خود با مشکلات و مسائلی روبرو میشود که ممکن است دشوار یا اضطرابآور به نظر برسند. بسیاری از توسعهدهندگان موفق اذعان میکنند که در آغاز حرفهی خود، اشتباهات بسیاری را مرتکب شدهاند، که بعدها به این اشتباهات پی بردهاند یعنی شاید ماهها و حتی سالها بعد متوجه این حقیقت شدهاند. همهی این افراد آرزو داشتند که میتوانستند زودتر از این، به نکات و راهنماییهای لازم به منظور دستیابی به موفقیت دسترسی داشته باشند تا بدین ترتیب بتوانند از هدر رفتن زمان خود به منظور درک نقشها و وظایف خود به عنوان یکی از اعضای تیم برنامهنویسی، اجتناب کنند.

در این مطلب، به نکاتی اشاره میکنیم که توسعهدهندگان حرفهای به توصیه در مورد آنها پرداختهاند تا به شما کمک کنند که بتوانید به عنوان یک برنامهنویس هر چه زودتر به موفقیت دست پیدا کنید و از بروز مشکلات اجتناب کنید.

۱- کار گروهی از ضرورت بسیاری برخوردار است.زمانی که با تیم خود کار میکنید، نمیتوانید از برقراری ارتباط با دیگران اجتناب کنید. و حتی اگر بتوانید به هر نحوی از این ارتباطات اجتناب کنید، کدهای شما باید با کدهایی که توسط دیگران نوشته شده است در ارتباط باشد. مهم نیست که به عنوان یک برنامهنویس از چه مهارتهایی برخوردارید، شما باید یاد بگیرید که چگونه با همتیمیهای خود ارتباط و همکاری داشته باشید تا از شکست خوردن اجتناب کنید.

لازم نیست که همهی افراد تیم خود را دوست داشته باشید ، اما باید قادر باشید تا با آنها کار کنید. بنابراین زبان افراد را به اندازهی زبان برنامهنویسی بیاموزید!

۲- از سوال پرسیدن نترسید.سوال پرسیدن روش خوبی برای یادگیری است، همانطور که میتواند یک فرصت مناسب برای شما به منظور برقراری ارتباط با همکارانتان باشد.

قبل از پرسیدن یک سوال فنی، سعی کنید که خودتان از طریق جستجو در اینترنت پاسخ آن سوال را پیدا کنید. به عنوان مثال، اگر شما یک توسعهدهندهی PHP هستید، درست نیست که از همکار خود بپرسید “من میخواهم یک آرایه مثل {۱, ۲, ۳, …, n, n-1} در PHP ایجاد کنم، میتوانید در این مورد به من کمک کنید؟ ” شما با پرسیدن این سوال نشان دادهاید که نه تنها در PHP از کمبود مهارت برخوردارید، بلکه زحمت جستجو کردن در گوگل و یا فکر کردن در مورد آن را نیز به خود ندادهاید .

۳- ابتدا فعالیتهای دارای اولویت را تکمیل کنید.این مورد ممکن است بسیار واضح به نظر برسد، اما به یاد داشته باشید: شما باید فعالیتهایی که از اولویت برخوردار هستند را انتخاب کنید، حتی اگر مواردی که از اولویت کمتری برخوردارند، برای شما جالبتر به نظر برسند. رفتار حرفهای داشته باشید.

۴- در مورد چیزهایی که نمیدانید نگران نباشید.ممکن است در معرض بحثهای فنی بسیاری قرار بگیرید که پر از کلمات و عباراتی هستند که ممکن است برای شما بیمعنی باشند. لازم نیست که مضطرب شوید و زمان خود را با نگرانی در مورد نکاتی که چیزی از آنها نمیدانید، هدر دهید. در دنیای کامپیوتر، موضوعات و مباحث بینهایتی برای یاد گرفتن وجود دارند. همچنین فهرستی از کلمات بینهایتی نیز وجود دارند که ممکن است در ابتدا معنای هیچ یک از آنها را متوجه نشوید. اما اگر به یاد گرفتن آنها ادامه دهید، در نهایت معنای آنها را متوجه خواهید شد.

۵- به دست آوردن یک شغل ، به معنای پایان یافتن یادگیری نیست.در کنار به روز بودن در مورد اخبار جهان، شما نیاز دارید تا در یادگیری مهارتها و ابزارهای جدید نیز به روز باشید. و این مسئله تقریبا در مورد تمامی حرفهها صدق میکند و برنامهنویسی نیز از آن مجزا نیست. با به روز کردن مهارتهای خود، بیشتر و بیشتر پیشنهادهای کاری دریافت خواهید کرد.

مهمترین عامل در موفقیت شما، خود شما هستید. تنها لازم است برای انجام دادن حرفهی خود به بهترین شکل، مسئولیتپذیر باشید.

برگرفته از: www.sololearn.com

How to Trace an IP Address

How to Trace an IP Address

An IP address is a fascinating product of modern computer technology designed to allow one computer (or other digital device) to communicate with another via the Internet. IP addresses allow the location of literally billions of digital devices that are connected to the Internet to be pinpointed and differentiated from other devices. In the same sense that someone needs your mailing address to send you a letter, a remote computer needs your IP address to communicate with your computer.

"IP" stands for Internet Protocol, so an IP address is an Internet Protocol address. An Internet Protocol is a set of rules that govern Internet activity and facilitate completion of a variety of actions on the World Wide Web. Therefore an Internet Protocol address is part of the systematically laid out interconnected grid that governs online communication by identifying both initiating devices and various Internet destinations, thereby making two-way communication possible.

An IP address consists of four numbers, each of which contains one to three digits, with a single dot (.) separating each number or set of digits. Each of the four numbers can range from 0 to 255. Here's an example of what an IP address might look like: 78.125.0.209. This innocuous-looking group of four numbers is the key that empowers you and me to send and retrieve data over our Internet connections, ensuring that our messages, as well as our requests for data and the data we've requested, will reach their correct Internet destinations. Without this numeric protocol, sending and receiving data over the World Wide Web would be impossible.

IP addresses can be either static or dynamic. Static IP addresses never change. They serve as a permanent Internet address and provide a simple and reliable way for remote computers to contact you. Static IP addresses reveal such information as the continent, country, region, and city in which a computer is located; the ISP (Internet Service Provider) that services that particular computer; and such technical information as the precise latitude and longitude of the country, as well as the locale, of the computer. Many websites provide IP address look-up services to their visitors, free of charge. If you're curious about your own IP address, you can locate these websites by performing a Google search.

Now, how these IP addresses can be fined? Here we show you how you can find your own IP address and a websites IP address.

1. Finding your own IP address:

As you already know, everyone in the internet have a unique IP address, or more correctly public IP address. If you are interested in finding out what your IP is use one of the following ways:

google.com: Go to the google website and search "my IP address"

ip-tracker.org: Go to the website www.ip-tracker.org and you can see it shows your IP address along with other information about you, including your ISP, your address, and etc.

ip-lookup.com: This website (www.ip-lookup.com) just shows your IP address

2. Finding a website's IP address:

Then you can look all information about website owners in http://www.ip-tracker.org website, including it's address on google map.

As you can see in the picture the rout from your computer to the website is traced and shown by IP addresses.

by Havar Bathaee